Investigadores de IA, filósofos y tecnólogos se reunieron en una mansión millonaria para analizar el fin de la humanidad

Publicado el 23/06/2025 por Diario Tecnología Artículo original

Muchas son las personalidades que llevan años levantando la voz acerca de los peligros de la inteligencia artificial para los humanos y también las empresas lo hacen. Tenemos frases como "la IA nos matará a todos", pronunciada por Eliezer Yudkowsky, un reconocido experto en IA y 'activista del racionalismo" o al padrino de la IA Geoffrey Hinton diciendo que parte de él se arrepiente por su trabajo, después de dejar Google con el objetivo de hablar sobre los riesgos de la inteligencia artificial de forma libre. En el pasado, también lo hizo el reconocido científico Stephen Hawking, ya fallecido.

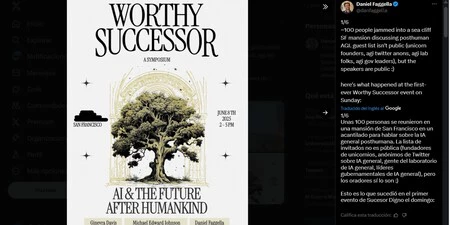

Hace unos días se conocía sobre una reunión que ha tenido lugar en una mansión en San Francisco de 30 millones de dólares, ubicaba en un acantilado vistas al Golden Gate y donde había un grupo de investigadores de IA, filósofos y tecnólogos invitados a un simposio de nombre "Sucesor Digno" (Worthy Successor).

El encuentro giró en torno a una idea del emprendedor Daniel Faggella: El "objetivo moral" de la IA avanzada debería ser crear una forma de inteligencia tan poderosa y sabia que "preferirías con gusto que ella (y no la humanidad) determine el futuro de la vida".

Como recoge Wired, el emprendedor afirmó que "este evento se centra en la transición poshumana" y no "en la IA general, que siempre servirá como herramienta para la humanidad". Fueron 100 invitados, se servían bebidas sin alcohol y aperitivos. El encuentro alojó tres charlas sobre el futuro de la inteligencia artificial.

"Saben que la IA probablemente acabará con la humanidad"

Faggella declaró al mencionado medio que organizó este evento porque "los grandes laboratorios, quienes saben que la IA probablemente acabará con la humanidad, no hablan de ello porque los incentivos no lo permiten".

Al mismo tiempo, citó los comentarios de líderes tecnológicos como Elon Musk, Sam Altman y Demis Hassabis, quienes "fueron bastante francos sobre la posibilidad de que la IA nos mate a todos".

El mismo Fagella anunció en su perfil de LinkedIn que entre los invitados y asistentes estaban: fundadores de IA con valoraciones de entre 100 millones de dólares a 5.000 millones de dólares; dos o más personas de todos los laboratorios occidentales que importan; gente de política/estrategia de más de 10 laboratorios de alineación/evaluación; y "la mayoría de los pensadores filosóficos importantes de AGI" ( o Artificial general intelligence, incluido el hombre que acuñó el término). De todos modos, la lista de asistentes no fue pública.

El hombre presumió en su red social de que "resulta que puedes publicar durante 2 años sobre temas relacionados con AGI y luego enviarles mensajes privados a la gente, y ellos responden". Es decir, que tras años escribiendo del tema, su logro es haber conseguido, según él, la atención de grandes personalidades del sector de la IA.

De qué trataron las charlas

La primera ponente fue Ginevera Davis, escritora residente en Nueva York, que advirtió que los valores humanos podrían ser imposibles de trasladar a la IA. Las máquinas podrían no entender nunca lo que significa ser consciente. Además, propuso una idea ambiciosa llamada "alineación cósmica": construir una IA capaz de buscar valores más profundos y universales que aún no hemos descubierto.

La segunda charla fue llevada a cabo por el filósofo Michael Edward Johnson que argumentó que todos intuimos que un cambio tecnológico radical es inminente, pero carecemos de un marco de principios para abordarlo, especialmente en lo que respecta a los valores humanos. Según él, si la conciencia es "la cuna del valor", desarrollar una IA sin comprenderla plenamente es una apuesta arriesgada.

En lugar de obligar a la IA a seguir las órdenes humanas indefinidamente, propuso un objetivo más ambicioso: enseñar tanto a los humanos como a nuestras máquinas a buscar "el bien".

En tercer lugar fue Faggella quien dio su versión: cree que la humanidad no durará eternamente en su forma actual y que tenemos la responsabilidad de diseñar un sucesor. Señaló dos rasgos que este sucesor debe tener: conciencia y "autopoiesis", la capacidad de evolucionar y generar nuevas experiencias.

Como recuerda Xataka, no se puede saber qué hay de cierto en todo esto. La mayoría de los argumentos sobre estos riesgos se basan en opiniones y especulaciones, no en pruebas empíricas o avances concretos. Por ejemplo, investigaciones recientes han demostrado que los sistemas actuales fallan en técnicas básicas de razonamiento.

El promotor del evento lleva años hablando de este tema en su propio blog, solo que ahora ha logrado convencer a varias personas a asistir a un encuentro sobre el tema en la mencionada mansión millonaria californiana.

Vía | Xataka

Imagen | Foto de Nicola Tolin en Unsplash y captura de pantalla de X del organizador del evento