Todo empieza pidiéndole una cosa a una IA. Cuando la IA se lo pide a otras IA comienza el caos

Publicado el 19/06/2025 por Diario Tecnología Artículo original

En el juego del "teléfono escacharrado" (o roto, o descompuesto) un grupo de personas transmite un mensaje de uno en uno en secreto. Lo que suele suceder es que el mensaje original no tiene mucho que ver con lo que recibe el último destinatario. Y el problema que estamos viendo es que algo similar puede ocurrir con los prometedores agentes de IA.

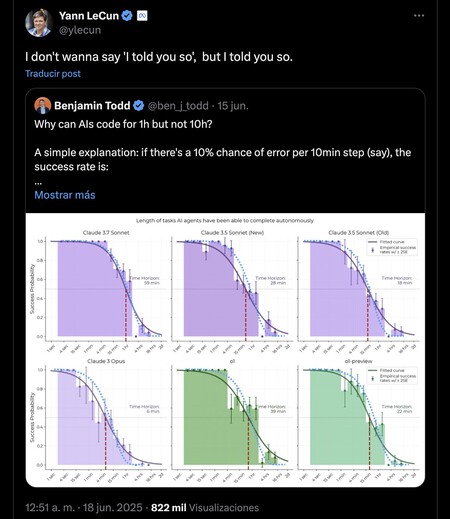

Errores acumulados. Toby Ord, investigador en la Universidad de Oxford, publicó recientemente un estudio sobre agentes de IA. En él hablaba de cómo este tipo de sistemas tienen el problema del error acumulado o compuesto. Un agente de IA encadena varias etapas de forma autónoma para tratar de resolver un problema que le proponemos —por ejemplo, crear código para cierta tarea—, pero si comete un error en una etapa, ese error se acumula y se hace más preocupante en la siguiente etapa, y más en la siguiente, y más aún en la siguiente. La precisión de la solución se ve así comprometida y puede no tener mucho (o nada) que ver con la que realmente solucionaría el problema que queríamos resolver.

La IA puede programar, pero no durante mucho tiempo seguido. Lo que planteaba este experto era la introducción de la llamada "vida media" del agente de IA, que ayudaría a estimar la tasa de éxito según la longitud de la tarea que quiere resolver un agente de IA. Por ejemplo, un agente con una vida media de 2 horas tendría un 50% de éxito en tareas de dos horas. El mensaje es contundente: cuanto más tiempo trabaja un agente de IA, más probabilidades hay de que la tasa de éxito decaiga. Benjamin Todd, otro experto en IA, lo expresaba de otra forma: una IA puede programar durante una hora sin (apenas) errores, pero no durante 10 horas. No son cifras reales ni definitivas, pero expresan el mismo problema: los agentes de IA no pueden —al menos de momento— funcionar de forma indefinida, porque los errores acumulados condenan la tasa de éxito.

Los humanos tampoco nos salvamos. Pero cuidado, porque algo muy parecido pasa con el rendimiento humano en tareas prolongadas. En el estudio de Orb se señalaba cómo la tasa de éxito empírica va bajando de forma notable: tras 15 minutos ya es de aproximadamente el 75%, tras hora y media es del 50% y tras 16 horas de apenas el 20%. Todos podemos cometer errores al realizar ciertas tareas encadenadas, y si en una de ellas cometemos un error, en la siguiente tarea de la cadena ese error condena todo el desarrollo posterior aún más.

LeCun ya avisó. Yann LeCun, que dirige los esfuerzos de investigación de IA en Meta, lleva mucho tiempo avisando de los problemas con los LLM. En junio de 2023 indicó cómo los LLM autoregresivos no pueden ser factuales y evitar respuestas tóxicas. Explicó que hay una alta probabilidad de que el token que genera un modelo nos lleve fuera del grupo de respuestas correctas, y cuanto más larga es la respuesta, más difícil es que sea correcta.

Para eso está la corrección de errores. Para evitar el problema, necesitamos reducir la tasa de errores de los modelos de IA. Es algo muy conocido en ingenería software, donde siempre se recomienda realizar una revisión temprana de código siguiendo una estrategia "shift left" para el ciclo de desarrollo de software: cuanto antes se detecta un error, más fácil y barato es corregirlo. Y ocurre justo lo contrario si no lo hacemos: el coste de corregir un error crece exponencialmente cuanto más tarde se detecta en el ciclo de vida. Otros expertos apuntan a que el aprendizaje por refuerzo (Reinforcement Learning, RL) podría solucionar el problema, y aquí LeCun respondía que lo haría si tuviésemos datos infinitos para pulir el comportamiento del modelo, cosa que no tenemos.

Más que agentes, multiagentes. En Anthropic demostraron recientemente cómo hay una forma de mitigar aún más esos errores (y los posteriores errores acumulados): usar sistemas multiagénticos. Esto es: que múltiples agentes de IA trabajen en paralelo para luego confrontar sus resultados y determinar el camino o solución óptima.

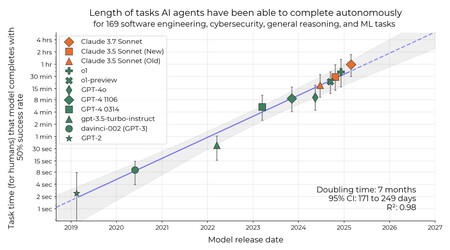

La gráfica muestra la longitud de las tareas que los agentes de IA pueden completar de forma autónoma a lo largo de los últimos años. El estudio revela que cada siete meses se dobla el tiempo que puede funcionar un agente de IA para completar tareas con una tasa de éxito del 50%. O lo que es lo mismo: los agentes están mejorando de forma sostenida (y notable) con el tiempo.

La gráfica muestra la longitud de las tareas que los agentes de IA pueden completar de forma autónoma a lo largo de los últimos años. El estudio revela que cada siete meses se dobla el tiempo que puede funcionar un agente de IA para completar tareas con una tasa de éxito del 50%. O lo que es lo mismo: los agentes están mejorando de forma sostenida (y notable) con el tiempo.

Pero los modelos y los agentes no paran de mejorar (¿o no?). El propio Todd apuntaba algo importante y que permite ser optimistas respecto a ese problema. "La tasa de error de los modelos de IA se está reduciendo a la mitad aproximadamente cada cinco meses", explicaba. Y a ese ritmo es posible que los agentes de IA puedan completar con éxito decenas de tareas encadenadas en año y medio y centenares en otro año y medio después. En The New York Times no estaban de acuerdo, y apuntaban recientemente a que aunque los modelos cada vez son más potentes, también "alucinan" más que anteriores generaciones. La "tarjeta de sistema" de o3 y o4-mini precisamente apunta a que hay un problema real con la tasa de errores y "alucinaciones" en ambos modelos.

utm_campaign=19_Jun_2025"> Javier Pastor .