Lo que DeepSeek acaba de lanzar no gustará ni a NVIDIA ni a las empresas de chips de Estados Unidos: su nombre es DeepSeek-V3.1

Publicado el 23/08/2025 por Diario Tecnología Artículo original

Cuando DeepSeek llegó, se sintió como la entrada de un elefante en una cacharrería, la de la apasionante batalla por la hegemonía de la IA mundial, hasta ese momento dominada (al menos de cara a la galería) por Occidente de la mano de ChatGPT. Pues bien, DeepSeek está de vuelta con V 3.1 y trae un aviso a navegantes: llega preparado para la próxima generación de chips chinos.

Si bien es cierto que esta afirmación en sí no constituye una revolución en el mercado, sí que dice alto y claro hacia qué dirección se mueve: hacia una ruta que no es precisamente cómoda para NVIDIA y fabricantes ajenos al país asiático. Porque si esa compenetración con el hardware chino se materializa en desempeño, esas conversaciones sobre quién nutre a la IA en China van a cambiar.

Como explica la publicación de la empresa, V 3.1 estrena una inferencia híbrida como la de GPT-5, es decir, un único sistema con dos rutas: el razonamiento profundo y la respuesta rápida, que se pueden elegir a través de un interruptor presente tanto en la versión web como en la app. Y no se limita a eso: la compañía destaca que la versión pensadora obtiene respuestas en menos tiempo que su predecesor.

Un nuevo modelo para los nuevos chips made in China

DeepSeek deja claro para quién es este nuevo modelo en sus redes sociales con un mensaje fijado: "UE8M0 FP8 es para la próxima generación de chips nacionales", dejando leer entre líneas que ha ajustado el formato de datos para la siguiente generación de chips chinos. Y no ha pasado desapercibido: tanto en Bloomberg como en Reuters han resumido que V3.1 está "personalizado para funcionar con chips de IA de próxima generación chinos", es decir, optimizado para el ecosistema nacional.

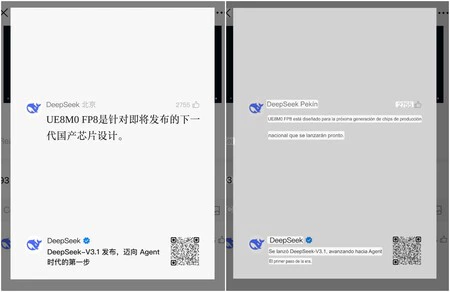

La publicación de DeepSeek en Chino y su traducción con Google Translate

La publicación de DeepSeek en Chino y su traducción con Google Translate

La model card oficial de Hugging Face detalla que DeepSeek-V3.1 "se ha entrenado usando el formato de escala UE8M0 FP8", lo que implica que tanto el entrenamiento como la ejecución está adaptada para funcionar de forma nativa. A nivel técnico, FP8 es un formato de 8 bits que pesa la mitad que FP16/BF16. Con un calibrado adecuado y este soporte nativo, permitiría más rendimiento por ciclo y menor uso de memoria.

¿Y NVIDIA, qué? Cabe recordar que los datos del pasado ejercicio fiscal desgranaban que China supone aproximadamente el 13% de los ingresos de la compañía estadounidense. Tiene sentido pensar que la porción de ese pastel procedente del país asiático se reducirá, dejando a un lado la combinación clásica de GPU NVIDIA + ecosistema CUDA a un lado en favor de esas soluciones domésticas con UE8M0 FP8, si estas últimas ofrecen buenos resultados.

Lo anterior per se ya invita a pensar en un giro de los acontecimientos, pero el contexto importa y mucho: con Estados Unidos estableciendo controles a la exportación, una forma de tratar de bloquear el acceso a China a la tecnología más puntera, este escenario ha funcionado como catalizador hacia la autosuficiencia. Un buen ejemplo que resume la situación es el caso del chip H20 de NVIDIA, primero bloqueado por la Administración Trump y luego permitido con condiciones. Ante un panorama político desfavorable, cambiante e inestable, la industria china se está moviendo hacia la independencia.

Según Financial Times, anteriormente DeepSeek trató de entrenar su futuro modelo R2 con chips Huawei Ascend de forma oficial, pero se encontró con problemas técnicos, lo que le hizo volver a NVIDIA para el entrenamiento mientras seguía profundizando en la compatibilidad para la inferencia. Esta situación deja en evidencia algo: la migración de todos los procesos no es fácil y requiere, entre otras cosas, tiempo. No obstante, la empresa ha afirmado su adaptación para los próximos chips chinos de forma rotunda.

El golpe de efecto es todavía más importante si se tiene en cuenta dónde está compitiendo DeepSeek. La plataforma MathArena asociada la Escuela Politécnica Federal de Zúrich y que pone a prueba a los modelos en competiciones matemáticas reales, destaca GPT-5 como vencedor absoluto en sus pruebas, pero DeepSeek-v3.1 (Think) está ligeramente por debajo. DeepSeek-v3.1 está disponible a través de la API.

Portada | DeepSeek + Philipp Katzenberger

En Genbeta | DeepSeek en local era justo lo que buscaba: una inteligencia artificial de calidad, privada y sin suscripciones

utm_campaign=23_Aug_2025"> Eva R. de Luis .