Hemos intentado utilizar la IA para verificar si las imágenes de la guerra entre Irán e Israel estaban hechas con IA. Ha sido un desastre

Publicado el 01/07/2025 por Diario Tecnología Artículo original

Que circulen imágenes falsas en redes sociales no es ninguna novedad, pero en la era de la IA cada vez es más difícil detectarlas y han conseguido que incluso desconfiemos de fotos reales. Que se viralicen fotos hechas con IA cuando sucede un evento importante es la nueva normalidad; lo vimos tras el apagón y también con el conflicto entre Israel e Irán. Nos queda claro que la IA es muy buena para generar imágenes falsas, pero ¿y si la usamos precisamente para lo contrario? No tanto.

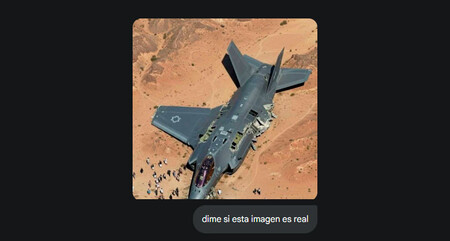

Las fotos en cuestión. Al mismo tiempo que un medio iraní publicaba la noticia de que Irán había derribado un F-35 israelí, dos imágenes empezaron a correr como la pólvora en redes sociales, aunque pronto supimos que eran falsas. Una de ellas, la del F35 estrellado y rodeado de curiosos, es especialmente llamativa. Para empezar, las proporciones no tienen ningún sentido: el avión parece gigante cuando en realidad mide 16 metros y las personas son más grandes que los edificios. Y eso por no mencionar que los daños del avión son mínimos para haber sido derribado.

Estas imágenes no fueron las únicas generadas por IA que circularon en los primeros días del conflicto. También aparecieron varios vídeos como este de un misil iraní enorme que parece bastante real hasta que vemos que se han dejado la marca de agua de Veo que delata que está hecho con IA, o este de una Tel Aviv destrozada.

La IA es terrible haciendo fact-check. Medios dedicados al fact-checking como Maldita ya desmintieron estas y otras imágenes creadas con IA en el contexto del conflicto entre Irán e Israel. Sin embargo, hubo usuarios que trataron de recurrir a herramientas de IA para comprobar la autenticidad de las imágenes y obtuvieron respuestas bastante confusas. Es lo que pasó en X con Grok. Un análisis de más de 130.000 posts reveló que la IA de Musk no era capaz de detectar algunas imágenes falsas o identificar las fuentes de las que provenían. Las notas de la comunidad escritas por los propios usuarios eran mucho más fiables.

Lo hemos probado. Para comprobar las capacidades de la IA, hemos usado la imagen del F-35 desproporcionado y le hemos preguntado a varias herramientas IA. Esto es lo que nos han respondido:

- ChatGPT: la herramienta de OpenAI empieza “esta imagen no parece real” y después procede a hacer un análisis de la proporción del avión, que identifica correctamente como un F35, y afirma que los daños no parecen coherentes.

- Perplexity: igual que ChatGPT, nos dice que las proporciones, perspectiva,y daños del avión y otros detalles sugieren que la foto ha sido manipulada digitalmente.

- Gemini: nos dice que la imagen es real, pero que no es de un ataque en combate, sino de un choque con aves que sucedió en Israel en 2017. Cuando le respondemos que nos muestre las fuentes, nos pasa varios enlaces con la noticia, pero en ninguno de ellos aparece la imagen. Después de un rato enviándonos información confusa, acaba reconociendo que se ha equivocado y nos pide disculpas por “el grave error”.

- Claude: es la única que afirma con contundencia que la imagen no es real y nos da el contexto exacto de lo que ha pasado “Esta es una de las muchas imágenes falsas que han circulado como parte de campañas de desinformación durante el conflicto entre Israel e Irán”.

La fiabilidad, asignatura pendiente. En nuestra prueba, Gemini se ha inventado por completo la respuesta, mientras que ChatGPT y Perplexity aciertan, aunque no se mojan. Claude es la única que nos da toda la información y acierta de lleno. Aunque los modelos de lenguaje han mejorado muchísimo en poco tiempo, siguen inventándose muchas respuestas a pesar de tener acceso a internet y poder hacer búsquedas. Sin duda, la fiabilidad es la asignatura pendiente de la IA generativa y donde más margen de mejora tiene.

Imágenes | 404 Media

En Xataka | Guía de ChatGPT: 22 funciones y cosas que puedes hacer para exprimir al máximo esta inteligencia artificial

utm_campaign=01_Jul_2025"> Amparo Babiloni .