AMD tiene una hoja de ruta espléndida para sus chips de IA. El problema sigue estando en su software

Publicado el 17/06/2025 por Diario Tecnología Artículo original

El problema de AMD no es que no haga buenas GPUs para IA. El problema es que aun desarrollándolas sigue sin poder competir con NVIDIA. La empresa acaba de plantear su renovada hoja de ruta con modelos prometedores, pero eso no es garantía de nada ante una NVIDIA que no va a dejar escapar su posición de liderazgo absoluto.

El problema para AMD no es estar, sino lograr que otros tomen nota. Datos de la consultora IDC indican que NVIDIA domina el mercado de los chips de IA con un 85,2% de cutoa de mercado, por un 14,3% de AMD. Otros analistas como Jon Peddie Research van más allá y según sus datos la cuota de NVIDIA en este segmento es del 92%.

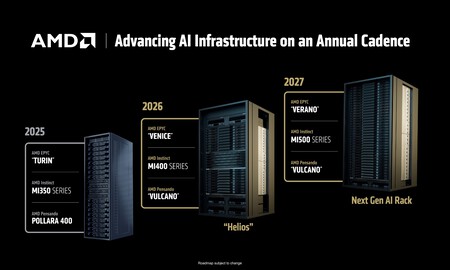

Las AMD Instinct MI350 son solo el principio. Las GPUs para IA, que AMD denomina "aceleradoras", siguen su evolución. Durante el evento presentaron su familia o serie Instinct MI350 con dos variantes, MI350X y MI355X. Según el fabricante, estos chips son cuatro veces superiores en rendimiento general respecto a la generación anterior, pero son hasta 35 veces más potentes en el ámbito de la inferencia IA (es decir, en el uso práctico de modelos como ChatGPT, que "infiere" sus respuestas a partir de nuestros prompts). Cuentan con 288 GB de memoria HBM3E y un ancho de banda de memoria de 8 TB/s. Su rendimiento es de 18,45 PFLOPS en precisión FP4 y de 9,2 PFLOPS en precisión FP8.

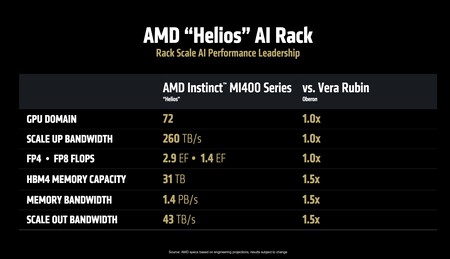

Instinct MI400 en 2026. El año que viene llegará la nueva familia de aceleradoras de IA de AMD. Se trata de las futuras Instinct MI400, que llegarán con hasta 432 GB de memoria HBM4, 19,6 TB/s de ancho de banda de esa memoria, y un rendimiento de 40 PFLOPS en precisión FP4 y 20 PFLOPS en precisión FP8. Estos monstruos se venderán en los futuros racks con infraestructura "Helios", que podrá albergar hasta 72 MI400 con hasta 260 TB/s de ancho de banda total gracias a su tecnología de interconexión, Ultra Accelerator Link.

EPYC Venice. AMD no solo habló de GPUs: también tiene en pleno desarrollo sus futuros procesadores para servidores en centros de datos. Los EPYC Venice llegarán en 2026 y estarán basados en la arquitectura Zen 6. Entre las variantes, una especialmente espectacular con 256 núcleos que ofrecerá hasta un 70% más de rendimiento respecto a la generación anterior. Estos procesadores se venderán emparejados con las futuras Instinct MI400. Se espera que unos y otros estén fabricados con el nodo N2P (2 nm) de TSMC.

Helios contra Oberon. El citado rack Helios competirá con no ya con el actual servidor de IA de NVIDIA, el GB200 NVL72 que conecta 36 CPUs Grace y 72 GPUs Blackwell. Está destinado a competir con su sucesor, que tiene como nombre en clave Oberon y que hará uso de GPUs de IA B300 con arquitectura Vera Rubin. Los rendimientos y prestaciones de estos futuros racks son absolutamente mareantes, y por ejemplo su potencia en precisión FP8 es de 1,4 ExaFLOPS.

Igual en unas cosas, mejor en otras. AMD promete igualar a NVIDIA en varios apartados, pero también asegura que la superará de forma notable (un 50% más) en cantidad y ancho de banda de memoria, algo crucial para el entrenamiento e inferencia IA. Cuidado, porque a finales de 2027 NVIDIA prepara la arquitectura Rubin Ultra, que promete racks con hasta 5 exaFLOPS en precisión FP8, tres veces más que Helios u Oberon.

En 2027 tendremos otro "Verano". La hoja de ruta de AMD va más allá, y ya tienen preparado el desarrollo de su nueva generación de chips para servidores EPYC Verano, , que reemplazarán a los EPYC Venice. Estas CPUs irán emparejadas con las futuras Instinct MI500X, y se espera —aunque no es seguro— que ambos tipos de chip aprovechen el ya anunciado nodo A16 de TSMC (1,6 nm), que comenzará a usarse a finales de 2026. No hay especificaciones de momento para estos desarrollos, seguramente porque dependerán del nodo de fabricación que AMD acabe usando para producirlos.

Carrera frenética. Todos estos anuncios demuestran que AMD no quiere ni mucho menos quedarse atrás en esa carrera por lograr situar sus soluciones en centros de datos en todo el mundo. La empresa Crusoe, que se dedica a la construcción de grandes centros de datos de IA, anunció hace unos días que gastaría 400 millones de dólares en chips de IA de AMD, y hasta Sam Altman, CEO de OpenAI, hizo una aparición sorpresa durante la charla inaugural del evento de Lisa Su, CEO de AMD. Altman aseguró que usarán también chips de AMD en los centros de datos que utilizan, y destacó que las nuevas GPUs de IA de AMD "van a ser algo asombroso".

AMD presume de ser más eficiente (y barata). El mensaje de AMD fue claro durante el evento: sus MI355 ofrecen mucha más eficiencia y son más baratos que los B200 y GB200 de NVIDIA con rendimients comparables. No se conocen los precios de venta de esas GPUs, pero sí sabemos que a principios de 2024 las MI300X de AMD costaban un máximo de 15.000 dólares por los más de 40.000 dólares que costaban las NVIDIA H100.

El mayor reto sigue siendo CUDA. Las prestaciones de los chips de IA de AMD no son de hecho el problema de esta compañía. Estudios detallados revelaron hace meses que las MI300X son claramente superiores a las H100 y H200 de NVIDIA en rendimiento y potencia. Sin embargo NVIDIA tiene CUDA, el estándar de facto en la industria para desarrolladores de servicios y aplicaciones de IA. Usar el software nativo de AMD es factible, sí, pero la experiencia software, aseguraban en SemiAnalysis, "software está plagada de errores que hacen que entrenar [modelos de IA] con AMD sea imposible".

La esperanza de AMD es ROCm. En ese evento AMD también presentó ROCm 7, la última versión de su propia plataforma Open Source de programación para sus GPUs. En AMD indicaron que esta versión es 3,5 veces más potente que ROCm 6, e incluso afirman que es un 30% más potente que CUDA en las B200 al servir el modelo DeepSeek R1. Aun así, indican en otro informe de SemiAnalysis, sigue siendo inferior en algunos apartados. Lograr que ese componente permita a los desarrolladores aprovechar todo el potencial de los chips de IA de AMD es precisamente clave para el futuro de esos esfuerzos. Más incluso que el hardware, ahora AMD debe apretar en el software.

Imagen | AMD

En Xataka | La directora general de AMD está en China con un propósito: arrebatar el mercado de la IA a NVIDIA

utm_campaign=17_Jun_2025"> Javier Pastor .