En una era donde la información fluye a una velocidad vertiginosa y la tecnología avanza a pasos agigantados, nos encontramos ante un desafío sin precedentes: diferenciar lo auténtico de lo sintético. La aparición y sofisticación de los ‘deepfakes’ ha transformado el paisaje mediático, político y social, introduciendo una capa de incertidumbre que, hasta hace poco, parecía ciencia ficción. Estas creaciones, generadas por inteligencia artificial, son capaces de simular voces, gestos y apariencias de personas con una exactitud asombrosa, hasta el punto de hacer casi indistinguibles de la realidad un vídeo o un audio fabricado. Lo que antes era un asunto de detección de burdos montajes, hoy se ha convertido en una prueba de fuego para nuestra percepción, nuestra capacidad crítica y, sorprendentemente, para nuestra edad. Un reciente estudio, cuyos hallazgos resuenan con una alarma palpable, ha puesto de manifiesto que la habilidad para discernir estas falsificaciones disminuye significativamente con la edad, abriendo un debate crucial sobre la alfabetización digital intergeneracional y la vulnerabilidad de segmentos específicos de la población frente a la desinformación. Este post explora la compleja naturaleza de los deepfakes, las implicaciones del estudio mencionado, y las estrategias que podemos adoptar para navegar en este nuevo y desconcertante panorama de la realidad simulada.

Qué son los deepfakes y por qué importan

El término ‘deepfake’ es una fusión de "deep learning" (aprendizaje profundo) y "fake" (falso), y se refiere a videos, imágenes o grabaciones de audio que han sido manipulados o generados por inteligencia artificial para presentar algo que nunca ocurrió, o para hacer que una persona diga o haga algo que en realidad no dijo ni hizo. La tecnología detrás de ellos se basa principalmente en redes generativas antagónicas (GANs), que enfrentan dos redes neuronales entre sí: una generadora que crea contenido falso y una discriminadora que intenta identificarlo como tal. Este proceso iterativo mejora continuamente la calidad del deepfake hasta que se vuelve casi indistinguible de la realidad para el ojo humano.

La proliferación de deepfakes no es un asunto trivial; sus implicaciones son profundas y multifacéticas. En el ámbito personal, pueden ser utilizados para difamar, acosar o extorsionar a individuos, con consecuencias devastadoras para su reputación y bienestar psicológico. A nivel social y político, los deepfakes representan una amenaza directa a la confianza pública y la estabilidad democrática. Pueden ser empleados para manipular elecciones, sembrar discordia, crear pánico colectivo o desestabilizar mercados financieros mediante la difusión de información falsa atribuida a figuras públicas. La capacidad de crear narrativas falsas convincentes erosiona la base de la verdad objetiva, haciendo cada vez más difícil para los ciudadanos tomar decisiones informadas. Desde mi punto de vista, la velocidad con la que esta tecnología ha madurado es asombrosa y aterradora a partes iguales, recordándonos que la ética y la regulación a menudo van a la zaga del progreso tecnológico. Para una comprensión más profunda de esta tecnología, se puede consultar este artículo sobre la historia y evolución de los deepfakes: Deepfake en Wikipedia.

El estudio revelador: edad y discernimiento de deepfakes

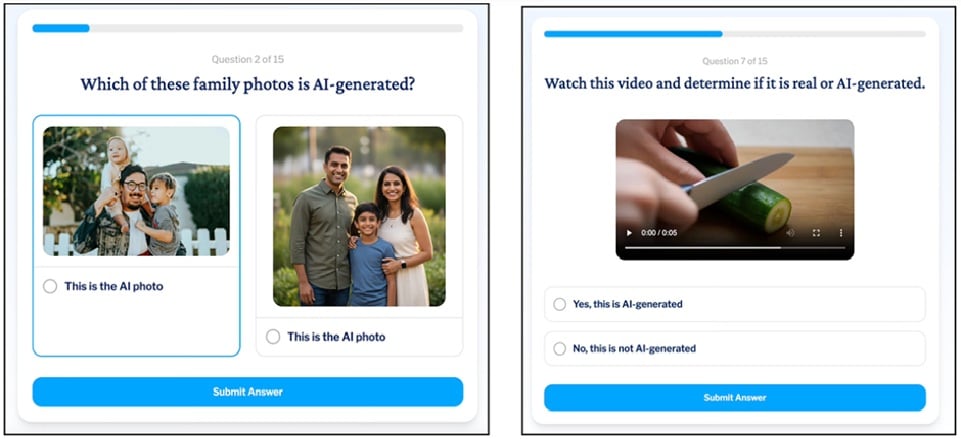

El núcleo de la preocupación actual surge de hallazgos como los de un estudio reciente que ha encendido las alarmas sobre la vulnerabilidad de ciertos grupos demográficos frente a los deepfakes. Este estudio, basado en cuestionarios y pruebas de detección visual y auditiva, reveló una correlación preocupante entre la edad y la capacidad para identificar contenido generado por IA. Específicamente, las personas mayores mostraron una dificultad significativamente mayor para distinguir entre videos y audios auténticos y sus contrapartes deepfake, en comparación con grupos de edad más jóvenes.

Existen varias hipótesis que intentan explicar esta brecha. Una de las más plausibles se relaciona con la brecha digital y la experiencia mediática. Las generaciones más jóvenes, "nativos digitales", han crecido en un entorno saturado de contenido digital, donde la edición y la manipulación de imágenes y videos son moneda corriente, incluso a través de filtros y aplicaciones cotidianas. Esto les otorga una familiaridad intuitiva con las imperfecciones y los signos sutiles de la alteración digital. Por el contrario, las personas mayores, habituadas a una era donde la imagen televisiva o la voz grabada eran consideradas pruebas irrefutables de la realidad, carecen a menudo de este "ojo entrenado" para detectar las anomalías más finas que delatan un deepfake. La confianza implícita en lo que se ve y se oye, forjada a lo largo de décadas de consumo de medios tradicionales, puede convertirse en una desventaja significativa en el panorama mediático actual. Este estudio subraya la necesidad urgente de programas de alfabetización digital adaptados a todas las edades. Por ejemplo, un estudio de la Universidad de California, Berkeley, ha explorado cómo las personas distinguen deepfakes: Berkeley News sobre detección de deepfakes.

Por qué los deepfakes son tan difíciles de detectar

La dificultad para detectar deepfakes no radica únicamente en la falta de familiaridad con la tecnología, sino también en la propia sofisticación de estos contenidos y en la forma en que interactúan con la psicología humana. En primer lugar, la mejora continua de los algoritmos de IA hace que los deepfakes sean cada vez más realistas, eliminando progresivamente las "imperfecciones" que antes los delataban, como parpadeos inconsistentes o texturas de piel antinaturales. Esta carrera armamentística tecnológica entre creadores y detectores es constante.

En segundo lugar, nuestros propios sesgos cognitivos juegan un papel crucial. El sesgo de confirmación, por ejemplo, nos hace más propensos a creer información que coincide con nuestras creencias preexistentes, independientemente de su veracidad. Si un deepfake refuerza una opinión que ya tenemos, somos menos propensos a cuestionar su autenticidad. La atención selectiva también influye; a menudo nos enfocamos en el mensaje principal sin prestar atención a los detalles sutiles que podrían revelar una manipulación. El impacto psicológico es inmenso: la posibilidad de que todo lo que vemos y oímos pueda ser falso erosiona la confianza en las fuentes de información y, en última instancia, en nuestra propia percepción de la realidad.

Indicadores visuales y auditivos a buscar

Aunque la tecnología avanza, aún existen ciertos signos que pueden ayudarnos a identificar un deepfake, aunque cada vez son más sutiles:

- Anomalías faciales y cutáneas: Preste atención a la textura de la piel (demasiado lisa o irregular), el brillo inconsistente, la forma o el movimiento de los ojos (a veces no miran directamente o el parpadeo es poco natural o ausente). Las asimetrías faciales que no son habituales en la persona real también pueden ser un indicio.

- Movimientos y gestos: Los deepfakes pueden presentar movimientos corporales o gestos de cabeza que parecen robóticos, repetitivos o antinaturales. La forma en que la persona se relaciona con el entorno puede ser incongruente.

- Sincronización labial y voz: Si la voz no coincide perfectamente con los movimientos de los labios, o si hay un desfase notable, es una señal de alarma. Las voces generadas por IA, aunque cada vez son mejores, a veces carecen de la entonación natural, las pausas, los acentos sutiles o las respiraciones que caracterizan el habla humana. Las distorsiones o ruidos de fondo anómalos también son pistas.

- Iluminación y sombras: La iluminación en un deepfake a menudo no es consistente con el entorno o con la fuente de luz aparente. Las sombras pueden ser incorrectas o inexistentes.

- Fondo y contornos: Los bordes alrededor de la persona pueden ser borrosos, pixelados o presentar artefactos digitales. El fondo puede parecer estático o artificial, o mostrar inconsistencias de perspectiva.

Mi observación personal es que, aunque estos indicadores son útiles, requieren un ojo muy entrenado y una atención al detalle que no siempre tenemos, especialmente cuando estamos inmersos en el consumo rápido de contenido digital.

Desafíos específicos para las generaciones mayores

La brecha digital es un factor clave en la vulnerabilidad de las generaciones mayores frente a los deepfakes. Muchas personas mayores no crecieron con internet, los teléfonos inteligentes o las redes sociales, y por lo tanto, su nivel de alfabetización digital puede ser menor. Esto no es una cuestión de capacidad intelectual, sino de experiencia y exposición a tecnologías que son nativas para las generaciones más jóvenes. Para ellos, la distinción entre un sitio web legítimo y uno fraudulento, o entre una noticia verificada y una “fake news”, puede ser más compleja.

Su experiencia con los medios tradicionales, donde la televisión, la radio y la prensa escrita tenían un alto grado de fiabilidad y veracidad (o al menos así se percibía), les ha inculcado una confianza que se traslada, a menudo sin filtrar, al contenido digital. Esta transferencia de confianza los hace particularmente susceptibles a estafas, desinformación política o noticias falsas que utilizan deepfakes para simular figuras de autoridad o personas de confianza. La desinformación dirigida a este grupo demográfico puede tener consecuencias económicas, sociales y hasta de salud pública muy graves.

Es imperativo reconocer que la alfabetización digital no es solo una habilidad técnica, sino también una habilidad crítica y social. La sociedad en su conjunto tiene la responsabilidad de reducir esta brecha, promoviendo programas de educación digital intergeneracionales que no solo enseñen el uso de herramientas, sino también el pensamiento crítico y la verificación de información. Iniciativas como las promovidas por organizaciones para combatir la desinformación en personas mayores son fundamentales: La OMS y la lucha contra la infodemia.

Herramientas y estrategias para la detección

Ante la amenaza creciente de los deepfakes, es fundamental desarrollar y aplicar estrategias tanto individuales como colectivas para detectarlos y mitigar su impacto. La primera línea de defensa es el pensamiento crítico. No todo lo que se ve o se oye en línea es verdad. Siempre debemos cuestionar la fuente, el contexto y la plausibilidad del contenido, especialmente si provoca una respuesta emocional fuerte o parece demasiado sensacionalista.

La verificación de fuentes es una herramienta poderosa. Si una noticia, video o audio parece sospechoso, intente buscar la misma información en múltiples fuentes de noticias reputadas y diversas. Si solo una fuente poco conocida lo reporta, es un indicador de cautela. Las organizaciones de verificación de hechos ("fact-checkers") desempeñan un papel crucial al analizar y desacreditar contenidos falsos.

Además, están surgiendo herramientas de detección de deepfakes basadas en IA. Estas herramientas utilizan algoritmos avanzados para analizar patrones, anomalías y metadatos que son invisibles para el ojo humano. Sin embargo, es importante recordar que estas herramientas también están en constante evolución y no son infalibles; lo que detectan hoy, los creadores de deepfakes intentarán superar mañana. La "carrera armamentista" entre la creación y la detección de deepfakes es un ciclo continuo.

El papel de los medios de comunicación y las plataformas digitales

Las plataformas de redes sociales y los medios de comunicación tienen una responsabilidad ineludible en la lucha contra los deepfakes. Deben implementar políticas estrictas para la identificación, etiquetado y eliminación de contenido manipulado. La transparencia sobre cómo se genera y distribuye la información es clave. Esto incluye desarrollar sistemas de advertencia para los usuarios cuando se comparte un deepfake, así como apoyar iniciativas de alfabetización mediática. Algunos están trabajando en la implementación de estándares de procedencia de medios, como el C2PA, que podrían ayudar a rastrear el origen de las imágenes y videos. La ética en la inteligencia artificial y la responsabilidad de las grandes empresas tecnológicas son debates en curso que necesitan soluciones urgentes. Más información sobre las herramientas de detección de deepfakes se puede encontrar en iniciativas de detección como la de MIT: MIT News sobre deepfakes.

Mi perspectiva sobre el futuro de los deepfakes y la sociedad

Como observador de las tendencias tecnológicas y sus repercusiones sociales, creo firmemente que la amenaza de los deepfakes no hará más que crecer en complejidad y alcance. La democratización de herramientas de IA para la creación de deepfakes, que ya están al alcance de cualquiera con un ordenador y cierta habilidad, significa que la capacidad de generar contenido falso convincente dejará de ser exclusiva de actores estatales o grandes organizaciones. Esto nos lleva a un futuro donde la desconfianza será la norma, y la verdad, una mercancía cada vez más escasa y difícil de verificar.

Sin embargo, no todo es pesimismo. Mi esperanza reside en la capacidad de adaptación y resiliencia humana, combinada con un esfuerzo coordinado. La educación es, sin duda, la herramienta más poderosa. Necesitamos invertir masivamente en alfabetización digital y mediática desde las escuelas hasta los centros de mayores, capacitando a las personas de todas las edades para que sean consumidores críticos de información. Además, la investigación en detección de deepfakes debe ser una prioridad, buscando soluciones tecnológicas que se mantengan a la vanguardia. Finalmente, la cooperación internacional y el desarrollo de marcos éticos y legales claros son esenciales para regular el uso de esta tecnología y responsabilizar a quienes la emplean con fines maliciosos. Es un desafío monumental, pero uno que la sociedad debe afrontar si queremos preservar la integridad de la información y la confianza mutua. También es importante recordar que la tecnología deepfake no es inherentemente maligna; tiene usos legítimos en campos como la creación de contenido artístico, la mejora de la accesibilidad o la educación, lo que complica aún más el panorama regulatorio. Para profundizar en la ética de la IA, recomiendo este recurso: Recomendación de la UNESCO sobre la Ética de la IA.

En definitiva, la capacidad para distinguir un deepfake no es solo una habilidad técnica, sino una competencia ciudadana fundamental en el siglo XXI. El cuestionario que nos obliga a discernir lo real de lo artificial no solo evalúa nuestra percepción, sino que desvela una vulnerabilidad generacional que exige una respuesta urgente y concertada. La tarea de construir una sociedad más informada y menos susceptible a la manipulación es una responsabilidad compartida que debe comenzar hoy mismo, con cada click, cada video y cada interacción digital que tengamos.

Deepfakes Alfabetización digital Desinformación Inteligencia artificial