En un mundo cada vez más interconectado y digital, la inteligencia artificial (IA) se ha erigido como una fuerza transformadora, prometiendo avances sin precedentes en campos tan diversos como la medicina, la ciencia y la comunicación. Sin embargo, como toda tecnología potente, la IA posee una doble filo. Su capacidad para generar contenido, automatizar procesos y analizar datos a una escala y velocidad antes inimaginables, también la convierte en una herramienta formidable para la manipulación. Estamos entrando en una era donde la línea entre lo real y lo sintético se difumina, y la protección contra las manipulaciones impulsadas por IA se ha convertido en una prioridad ineludible. ¿Cómo podemos discernir la verdad cuando la falsedad es cada vez más convincente y omnipresente? Esta pregunta, que antes sonaba a ciencia ficción, es hoy una realidad palpable y exige una respuesta colectiva y multifacética.

El desafío de la desinformación impulsada por IA

La manipulación con IA no es una preocupación futurista; es una amenaza presente que ya está dejando su huella en la sociedad. Desde la creación de "deepfakes" que alteran videos y audios para poner palabras en boca de personas que nunca las dijeron, hasta la generación de textos y noticias falsas que parecen indistinguibles de contenido legítimo, la IA ha escalado exponencialmente la capacidad de producir desinformación. Lo que antes requería equipos especializados y mucho tiempo, ahora puede ser realizado por cualquier persona con acceso a las herramientas adecuadas, y a una fracción del costo.

La sofisticación de estas técnicas es lo que las hace particularmente peligrosas. Los deepfakes de video, por ejemplo, pueden recrear expresiones faciales y gestos con una precisión asombrosa, haciendo que sea extremadamente difícil para el ojo humano, incluso el más entrenado, detectar la falsificación. De manera similar, los modelos de lenguaje grandes (LLM) pueden generar artículos, correos electrónicos e incluso ensayos completos con una coherencia gramatical y contextual que rivaliza con la escritura humana. Estos contenidos pueden ser utilizados para influir en opiniones políticas, difamar a individuos, inducir al fraude financiero o sembrar la discordia social a gran escala.

En mi opinión, la mayor amenaza no reside solo en la falsedad individual, sino en la erosión sistémica de la confianza. Cuando la gente no puede distinguir lo real de lo artificial, la fe en las instituciones, en los medios de comunicación y, en última instancia, en la propia realidad, se ve gravemente comprometida. Esto tiene implicaciones profundas para la democracia, la cohesión social y la toma de decisiones informadas.

Estrategias para protegerse a nivel individual

Si bien la magnitud del problema puede parecer abrumadora, el individuo tiene un papel crucial que desempeñar en la primera línea de defensa. Adoptar una mentalidad crítica y desarrollar habilidades de alfabetización digital son pasos fundamentales.

Pensamiento crítico y verificación de fuentes

La base de cualquier defensa contra la manipulación es el pensamiento crítico. Esto implica cuestionar la información que se consume, especialmente si genera una fuerte respuesta emocional o parece demasiado sensacionalista. Antes de compartir o aceptar un contenido, pregúntese:

- ¿Cuál es la fuente de esta información? ¿Es un medio reputado o un perfil desconocido?

- ¿Existen otras fuentes que confirmen o refuten esta información? La verificación cruzada es esencial.

- ¿El estilo o el tono del contenido parecen inusuales para la fuente o el tema?

- ¿Parece demasiado bueno o demasiado malo para ser verdad? A menudo, lo es.

Herramientas de verificación de hechos, como las ofrecidas por organizaciones independientes, pueden ser recursos invaluables. Es fundamental cultivar el hábito de no dar por sentado lo que vemos o escuchamos en línea, especialmente si proviene de canales no verificados.

Reconocimiento de patrones y señales de alarma

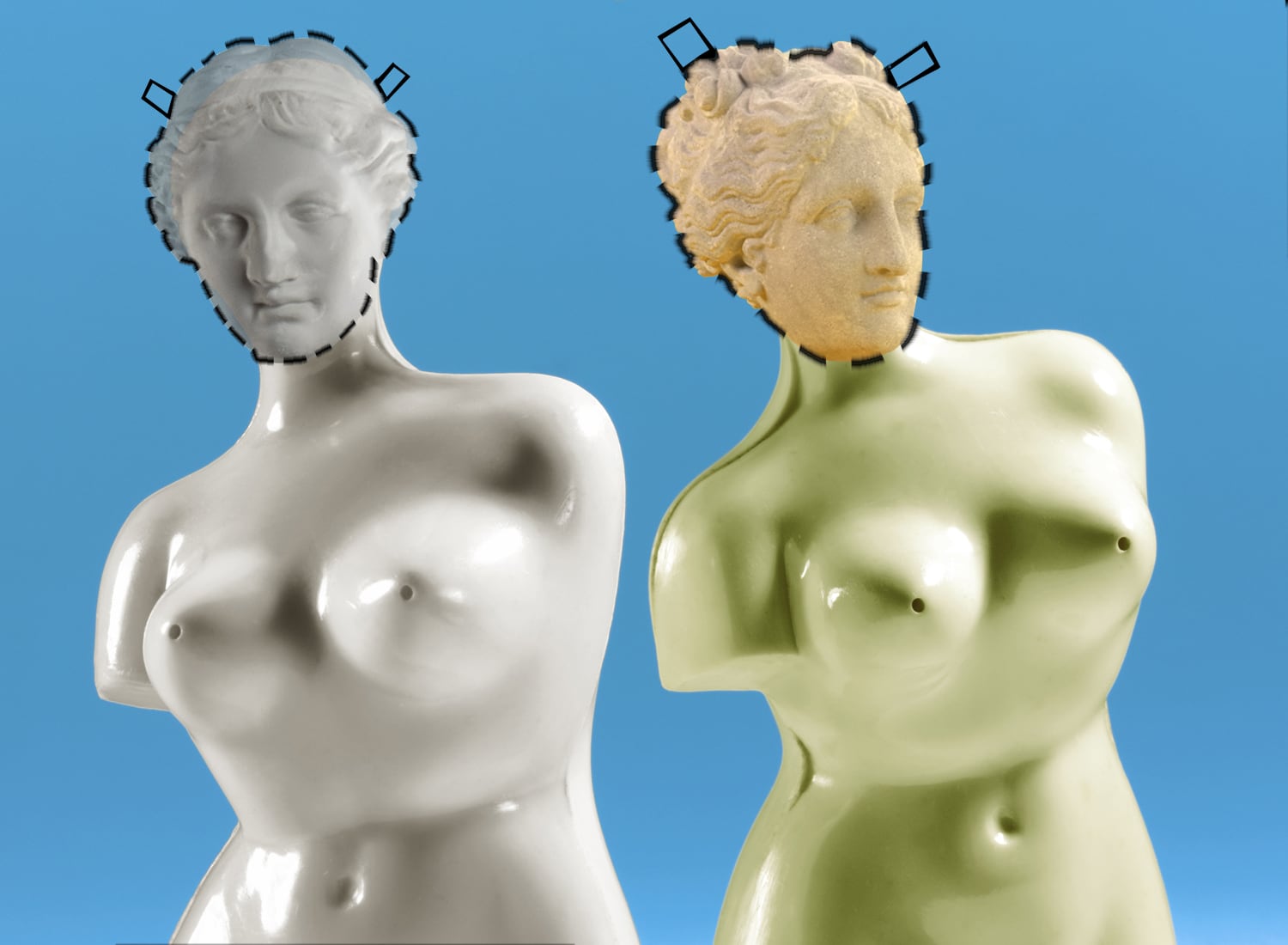

Aunque la IA se vuelve cada vez más sofisticada, aún existen ciertas señales que pueden indicar que un contenido es manipulado. En el caso de los deepfakes, por ejemplo, busque inconsistencias sutiles: parpadeos poco naturales, falta de sincronización labial, fondos inusuales o artefactos digitales. Para textos generados por IA, a veces puede haber una falta de profundidad emocional, repetición de frases o una estructura que, aunque gramaticalmente correcta, carece de la fluidez y la idiosincrasia de la escritura humana. Sin embargo, estas señales son cada vez más difíciles de detectar, lo que subraya la necesidad de ir más allá de la mera observación.

Soluciones tecnológicas y regulatorias colectivas

La protección contra la manipulación por IA no puede recaer únicamente en el individuo. Se requiere un esfuerzo concertado entre gobiernos, la industria tecnológica, la academia y la sociedad civil para construir un ecosistema digital más resiliente.

Desarrollo de IA contra IA

Paradójicamente, la misma tecnología que habilita la manipulación puede ser nuestra mejor aliada en la detección. Se están desarrollando algoritmos de IA especializados para identificar deepfakes, contenido sintético y patrones de desinformación. Estos sistemas pueden analizar metadatos, reconocer anomalías en la composición de imágenes o sonidos, e incluso identificar las "huellas digitales" de los modelos generativos. Sin embargo, esta es una carrera armamentista constante, donde los modelos de detección deben evolucionar tan rápido como los modelos de generación. La investigación en este campo es crucial y merece una inversión significativa.

Estándares y regulaciones éticas

Los gobiernos y los organismos internacionales tienen un papel fundamental en la creación de un marco ético y legal que regule el uso de la IA. Iniciativas como la Ley de IA de la Unión Europea (EU AI Act) buscan establecer directrices claras para el desarrollo y despliegue de sistemas de IA, con un enfoque particular en la transparencia, la responsabilidad y la seguridad. Es vital que estas regulaciones aborden explícitamente la generación de contenido sintético y la necesidad de etiquetar claramente el material creado por IA. Sin un marco legal sólido, las herramientas de manipulación podrían proliferar sin control. Considero que una regulación efectiva no debe sofocar la innovación, sino canalizarla hacia usos responsables y éticos. Para más información sobre la Ley de IA de la UE, puede consultar el siguiente enlace: Ley de IA de la UE.

Trazabilidad y autenticación de contenido

Una de las soluciones más prometedoras es la implementación de mecanismos de trazabilidad y autenticación para el contenido digital. Esto podría incluir marcas de agua digitales imperceptibles, metadatos verificables o incluso el uso de tecnologías de cadena de bloques (blockchain) para registrar el origen y las modificaciones de un archivo. Si el público pudiera verificar con facilidad la autenticidad de una imagen, video o audio, la tarea de los manipuladores sería exponencialmente más difícil. Organizaciones como la UNESCO también están trabajando en recomendaciones éticas globales para la IA, que incluyen principios de transparencia y rendición de cuentas. Puede ver sus recomendaciones aquí: Recomendaciones de la UNESCO sobre la Ética de la IA.

Colaboración internacional y multidisciplinaria

La manipulación por IA no respeta fronteras. Por lo tanto, la respuesta debe ser global y colaborativa. Gobiernos, la industria, la academia y la sociedad civil deben trabajar juntos para compartir conocimientos, desarrollar soluciones comunes y establecer mejores prácticas. Esto incluye la financiación de investigación, la organización de talleres y conferencias, y la creación de consorcios internacionales dedicados a la seguridad de la IA y la lucha contra la desinformación. La International Fact-Checking Network (IFCN) es un ejemplo de este tipo de colaboración, promoviendo la verificación de hechos a nivel global: International Fact-Checking Network (IFCN).

El papel de las plataformas y los medios de comunicación

Las grandes plataformas de redes sociales y los medios de comunicación tienen una responsabilidad inmensa en este desafío. Son los principales canales a través de los cuales la desinformación se propaga y, por lo tanto, deben invertir significativamente en soluciones.

Moderación de contenido mejorada con IA

Si bien la moderación manual es inviable a la escala actual de internet, las plataformas pueden utilizar IA para identificar y eliminar contenido manipulado de manera más eficiente. Esto requiere invertir en algoritmos de detección avanzados y en equipos de moderadores humanos que puedan supervisar y refinar estos sistemas.

Etiquetado y transparencia

Una práctica esencial es la de etiquetar explícitamente cualquier contenido generado o alterado por IA. La transparencia es clave para permitir que los usuarios tomen decisiones informadas sobre lo que están consumiendo. Algunas plataformas ya están empezando a implementar esto, pero se necesita un estándar universal y una aplicación rigurosa.

Educación del usuario y apoyo a la verificación de hechos

Las plataformas también pueden desempeñar un papel proactivo en la educación de sus usuarios sobre los riesgos de la manipulación por IA y cómo identificarla. Esto podría incluir campañas de concienciación, tutoriales interactivos y el apoyo a iniciativas de verificación de hechos de terceros. Un enfoque proactivo en la alfabetización digital es tan importante como la detección. Artículos de expertos en ciberseguridad pueden ofrecer una perspectiva valiosa sobre las amenazas emergentes: CISA sobre seguridad de la IA.

Hacia un futuro resiliente

La lucha contra la manipulación por IA es una batalla continua, no una guerra que se ganará de una vez por todas. A medida que la IA avanza, también lo harán las técnicas de manipulación. Por lo tanto, la resiliencia en este contexto significa una adaptación constante y una mejora continua de nuestras defensas.

La educación digital debe ser una parte fundamental del currículo en todos los niveles, desde la escuela primaria hasta la formación continua para adultos. No podemos esperar que la tecnología resuelva todos nuestros problemas; la capacidad humana para el pensamiento crítico y la ética es irremplazable. Es esencial que desarrollemos una cultura donde la verificación de la información sea un hábito instintivo, no una excepción.

Además, la colaboración entre los investigadores de IA y los expertos en ciencias sociales es crucial. Comprender no solo cómo se crea la desinformación, sino también por qué la gente la cree y cómo se propaga en diferentes contextos sociales y culturales, nos permitirá diseñar estrategias de defensa más efectivas. Los informes del Foro Económico Mundial, por ejemplo, a menudo destacan los riesgos de la desinformación global: Foro Económico Mundial - Riesgos globales y IA generativa.

En última instancia, protegerse contra las manipulaciones con IA es un imperativo para salvaguardar la verdad, la confianza y la integridad de nuestras sociedades. Es un desafío complejo que requiere una respuesta coordinada, tecnológicamente avanzada, éticamente sólida y profundamente humana. La IA es una herramienta; depende de nosotros asegurarnos de que se utilice para el bien y de que estemos preparados para defendernos de sus usos malintencionados.