Desde hace décadas, la 'Ley de Moore' ha sido mucho más que una simple observación; ha sido la brújula que ha guiado la industria tecnológica. La predicción de Gordon Moore de que el número de transistores en un microchip se duplicaría cada dos años, con una consecuente mejora en rendimiento y reducción de costos, no solo se cumplió, sino que se convirtió en una profecía autocumplida que impulsó una era de innovación sin precedentes. Esta constante aceleración fue la chispa que encendió la revolución de los ordenadores personales, internet y, en última instancia, sentó las bases para la inteligencia artificial moderna. Sin embargo, en el vertiginoso mundo de la IA, donde la capacidad de procesamiento y la complejidad de los modelos parecen crecer a un ritmo aún más explosivo, muchos han empezado a hablar de una 'Ley de Moore' de la IA. Pero, ¿es esta analogía un reflejo preciso de la realidad o una trampa conceptual que nos distrae de las barreras inminentes? Este artículo explorará la idea de este crecimiento exponencial en la IA y analizará por qué el sector tecnológico podría estar acercándose a un "techo invisible" mucho antes de lo que algunos optimistas quisieran admitir.

El eco de una predicción: la 'Ley de Moore' original y su legado

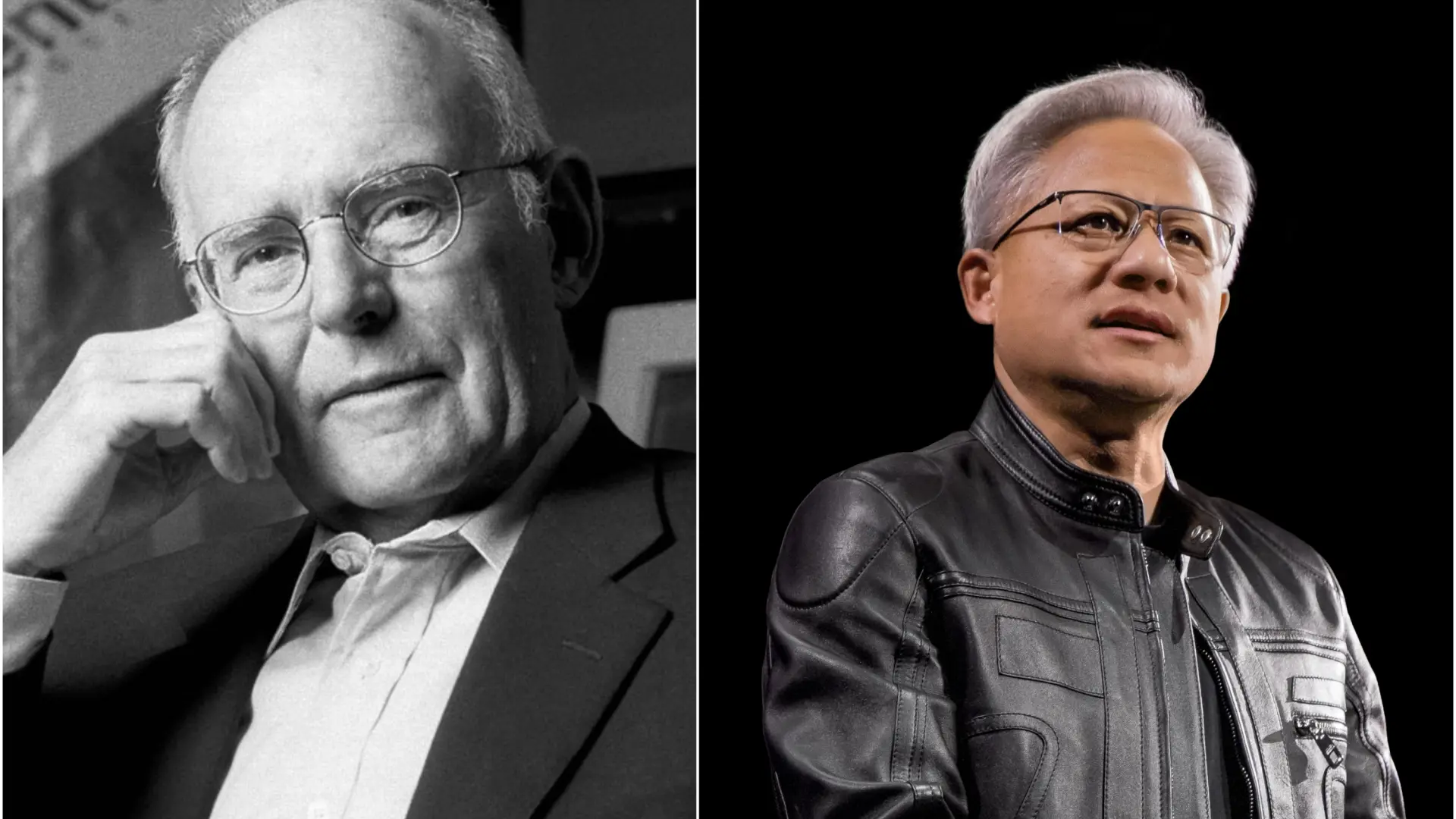

Antes de adentrarnos en las complejidades de la IA, es fundamental recordar el contexto de la 'Ley de Moore' original. En 1965, Gordon Moore, cofundador de Intel, publicó un artículo seminal en la revista Electronics donde observaba que la densidad de componentes en los circuitos integrados se duplicaba aproximadamente cada año, y luego revisó esta estimación a cada dos años. Esta observación no era una ley física inquebrantable, sino una tendencia empírica impulsada por la ingeniosidad de la ingeniería y la presión del mercado. La miniaturización de transistores permitió no solo chips más potentes, sino también más baratos, lo que democratizó el acceso a la tecnología y abrió la puerta a innumerables innovaciones.

Durante casi 50 años, esta ley impulsó la investigación y el desarrollo, creando una hoja de ruta para fabricantes de chips, diseñadores de software y la industria tecnológica en general. Sin embargo, en los últimos años, la 'Ley de Moore' ha mostrado signos de desaceleración. Los límites físicos de la nanotecnología, el calor generado en los chips y los costos astronómicos de fabricación de nodos cada vez más pequeños han hecho que mantener el ritmo sea cada vez más difícil. Aunque la industria ha respondido con arquitecturas innovadoras como la computación en paralelo y los procesadores especializados (GPUs, TPUs), la era de la duplicación constante de transistores en un solo chip parece estar llegando a su fin, transformándose quizás en una ley de "más allá de Moore" o "más de Moore", donde la innovación se centra en la integración heterogénea y la eficiencia. Para un repaso profundo de la historia y el futuro de esta ley, el artículo de Intel sobre su legado es muy ilustrativo: La Ley de Moore: Historia y futuro.

¿Existe una 'Ley de Moore' en la inteligencia artificial? Interpretaciones y desafíos

En el ámbito de la inteligencia artificial, la noción de una 'Ley de Moore' particular ha surgido en varias formas, todas ellas ligadas a la idea de un crecimiento exponencial. Una de las interpretaciones más populares se refiere a la cantidad de cómputo utilizada para entrenar los modelos de IA más avanzados. Investigadores de OpenAI observaron que la cantidad de cómputo utilizada en los entrenamientos más grandes ha estado duplicándose aproximadamente cada 3.4 meses desde 2012, superando con creces el ritmo de la 'Ley de Moore' original. Esto se ha traducido en un aumento asombroso en el tamaño de los modelos, medido en el número de parámetros, pasando de millones a miles de millones y ahora a billones. Modelos como GPT-3, PaLM, LLaMA y muchos otros han demostrado que, hasta ahora, más parámetros y más datos, combinados con más cómputo, a menudo conducen a un mejor rendimiento.

Este crecimiento no solo se observa en el cómputo o el tamaño del modelo, sino también en el rendimiento de los sistemas de IA en tareas específicas, como el reconocimiento de imágenes, el procesamiento del lenguaje natural o incluso juegos complejos. La capacidad de superar puntos de referencia, a veces de forma dramática, ha reforzado la creencia de que estamos en una trayectoria de mejora continua e ilimitada. En mi opinión, esta "ley" de la IA, si bien ha sido un excelente descriptor del progreso reciente, es más una consecuencia del ciclo virtuoso de inversión, avance algorítmico y disponibilidad de datos, que una ley fundamental intrínseca al desarrollo de la inteligencia. Es importante reconocer esta distinción, ya que las consecuencias de la primera son muy diferentes a las de la segunda. El informe de OpenAI "AI and Compute" ofrece una perspectiva clave sobre esta tendencia: AI y cómputo.

Los pilares de la escalada: ¿hasta cuándo podemos sostenerlos?

Si la 'Ley de Moore' de la IA es una descripción del crecimiento actual, los fundamentos sobre los que se asienta son los que determinarán su sostenibilidad. Y es aquí donde empezamos a vislumbrar ese "techo invisible".

Cómputo y energía: una demanda insaciable y sus límites

El motor principal detrás del crecimiento de la IA es el cómputo. El entrenamiento de grandes modelos requiere una cantidad colosal de procesamiento, dominada por hardware especializado como las Unidades de Procesamiento Gráfico (GPUs) y las Unidades de Procesamiento Tensorial (TPUs). Aunque el avance en el diseño de estos chips ha sido impresionante, también enfrentan sus propios límites físicos y económicos. La disipación de calor, la latencia de la memoria y la velocidad de interconexión son barreras ingenieriles persistentes.

Más allá del hardware, la energía es una preocupación creciente. Entrenar un modelo de lenguaje grande puede consumir tanta energía como la que gastan decenas o incluso cientos de hogares en un año. Esto plantea serias preguntas sobre la huella de carbono de la IA y la sostenibilidad a largo plazo de esta trayectoria de escalada. Los centros de datos consumen cantidades masivas de electricidad, y a medida que los modelos se hacen más grandes y más frecuentes, la demanda energética solo aumentará, afectando tanto los costos operativos como el impacto ambiental. Este es un punto que considero crucial y que a menudo se subestima en las discusiones sobre el futuro de la IA. La energía no solo es un factor económico, sino también un imperativo ético en la era del cambio climático. Para entender mejor la energía consumida, un estudio de la Universidad de Massachusetts Amherst da algunas cifras preocupantes: Estimando la huella de carbono del entrenamiento de grandes modelos de aprendizaje profundo.

Datos y su calidad: la próxima escasez

Otro pilar fundamental de la IA moderna son los datos. Los modelos de aprendizaje profundo requieren vastas cantidades de datos para aprender patrones complejos y generalizar. Internet ha sido una mina de oro para esto, pero la web no es infinita, y la calidad de sus datos es heterogénea. Ya estamos empezando a ver signos de "agotamiento" de datos de alta calidad y diversidad. Si bien aún hay muchos datos en el mundo, la extracción, curación y anotación de los mismos para fines de IA es costosa, consume mucho tiempo y, en muchos casos, plantea serias preocupaciones éticas y de privacidad.

Además, no todos los datos son igualmente útiles. Para lograr la verdadera inteligencia, los modelos necesitan aprender no solo de grandes cantidades de texto o imágenes, sino también de interacciones complejas con el mundo, del sentido común y del conocimiento contextual. Estos tipos de datos son mucho más difíciles de recopilar y estructurar a gran escala. La escasez de datos específicos para dominios nicho o para tareas que requieren razonamiento profundo podría convertirse en un cuello de botella significativo, forzando a los desarrolladores a buscar enfoques más eficientes con los datos, en lugar de simplemente escalar su volumen.

Costos económicos y acceso: la centralización del poder

El costo de entrenar modelos de IA de vanguardia es prohibitivo para la mayoría de las organizaciones. Los gastos pueden ascender a decenas o cientos de millones de dólares, lo que limita la capacidad de desarrollar y experimentar con modelos a unas pocas grandes corporaciones tecnológicas con presupuestos ilimitados. Esta concentración de recursos tiene varias implicaciones preocupantes:

- Centralización del poder: Unas pocas entidades controlan las arquitecturas más avanzadas, los modelos base y, por extensión, las direcciones futuras de la investigación y el desarrollo de la IA.

- Barrera para la innovación: Las startups, los investigadores académicos y los proyectos de código abierto se encuentran en una desventaja significativa, ya que carecen del capital para competir en la carrera de la escala. Esto podría sofocar la diversidad de enfoques y la creatividad que a menudo proviene de entornos más descentralizados.

- Impacto en la transparencia y la ética: La falta de acceso y la opacidad de los modelos gigantes dificultan la auditoría, la mitigación de sesgos y el desarrollo de IA responsable.

Esta barrera económica es, en mi opinión, una de las más insidiosas, ya que no se trata de un límite físico, sino de una restricción de acceso que puede moldear el futuro de la IA de maneras poco democráticas.

Límites algorítmicos y teóricos: ¿estamos solo escalando soluciones existentes?

Gran parte del progreso reciente en IA, especialmente en el ámbito de los modelos de lenguaje grandes (LLMs), se ha logrado escalando arquitecturas existentes, como los transformadores. Si bien estas arquitecturas han demostrado ser increíblemente robustas y escalables, existe un debate sobre si la simple escalada continuará brindando ganancias marginales en el futuro o si se necesitan avances algorítmicos y teóricos fundamentales.

¿Estamos realmente acercándonos a la inteligencia general artificial (AGI) a través de la fuerza bruta del cómputo y los datos, o simplemente estamos creando máquinas más grandes y sofisticadas para la "interpolación y el reconocimiento de patrones"? Muchos investigadores argumentan que la inteligencia humana va más allá de esto, implicando razonamiento causal, sentido común, comprensión contextual profunda y la capacidad de aprender con muy pocos ejemplos. Estos aspectos podrían requerir cambios fundamentales en la forma en que diseñamos y entrenamos los sistemas de IA, más allá de simplemente hacerlos más grandes. La "Ley de Moore" de la IA podría ser la historia de la madurez de una tecnología específica (el aprendizaje profundo a gran escala), no de la inteligencia en sí misma.

Más allá de la escala: el futuro de la innovación en IA

El reconocimiento de estos techos invisibles no debería ser motivo de pesimismo, sino un catalizador para una nueva fase de innovación. Si ya no podemos depender únicamente de la escalada masiva, el futuro de la IA deberá centrarse en la eficiencia, la ingeniosidad y la inteligencia en su diseño.

Eficiencia y optimización: haciendo más con menos

La presión sobre el cómputo y la energía ya está impulsando la investigación en arquitecturas más eficientes. Esto incluye técnicas como la esparsificación, donde solo una fracción de los parámetros del modelo se activan para una tarea determinada, o arquitecturas de Mezcla de Expertos (MoE), que permiten modelos masivos pero activan selectivamente solo las partes relevantes. También veremos un mayor enfoque en el co-diseño de hardware y software, donde los algoritmos se optimizan para arquitecturas de chips específicas y viceversa. La computación neuromórfica, inspirada en el cerebro humano, también promete eficiencias energéticas radicales a largo plazo.

IA simbólica y neurosimbólica: fusionando paradigmas

Para superar las limitaciones actuales de los modelos puramente basados en datos y patrones, la integración de enfoques simbólicos con el aprendizaje profundo podría ser clave. La IA neurosimbólica busca combinar la capacidad del aprendizaje profundo para reconocer patrones y aprender de datos con la capacidad de la IA simbólica para razonar, planificar y manejar el conocimiento estructurado. Esto podría permitir sistemas de IA que no solo "reconocen" sino que también "entienden" y "razonan", un paso crucial hacia una inteligencia más robusta y general. Un ejemplo de este tipo de investigación se puede encontrar en los trabajos de Meta AI, que a menudo exploran diferentes paradigmas: Blog de Meta AI.

Diversificación y especialización: pequeños modelos con gran impacto

En lugar de construir modelos cada vez más grandes para resolver todos los problemas, podríamos ver una proliferación de modelos más pequeños y especializados, optimizados para tareas específicas. Los modelos de lenguaje pequeños (SLM) o los modelos fundacionales especializados que se ajustan finamente a dominios concretos pueden ofrecer un rendimiento superior con una fracción del costo y el consumo de energía. La IA en el borde (Edge AI), donde el procesamiento se realiza localmente en el dispositivo en lugar de en la nube, también es un área de crecimiento importante para aplicaciones eficientes y sensibles a la privacidad.

Ética y sostenibilidad: un imperativo de diseño

Finalmente, los techos invisibles que hemos discutido nos obligan a integrar la ética y la sostenibilidad como principios fundamentales en el diseño y desarrollo de la IA. La huella de carbono de la IA ya no puede ser una nota a pie de página; debe ser una consideración central. Lo mismo ocurre con la equidad, la transparencia y la explicabilidad de los modelos. Los investigadores y desarrolladores tienen la responsabilidad de construir sistemas de IA que no solo sean potentes, sino también responsables, justos y sostenibles. Este es un punto donde, en mi experiencia, la conversación está madurando rápidamente, pasando de un "sería bueno tener" a un "debe tener".

Conclusión

La 'Ley de Moore' de la IA ha sido una fuerza impulsora fenomenal, un testimonio del ingenio humano y la inmensa inversión en el campo. Ha catalizado una era de avances tecnológicos que están remodelando nuestras vidas y la sociedad a un ritmo sin precedentes. Sin embargo, como toda tendencia exponencial, tiene sus límites. Los techos invisibles del cómputo, la energía, la disponibilidad y calidad de los datos, los costos económicos y las limitaciones algorítmicas no son barreras insuperables, pero sí representan un punto de inflexión crucial.

Este no es el fin del progreso en IA, sino una llamada a la madurez. La fase de "escalada masiva" está dando paso a una era de "innovación inteligente". El futuro de la IA no residirá únicamente en la fuerza bruta, sino en la elegancia algorítmica, la eficiencia energética, la astucia en el uso de los datos y una profunda consideración por las implicaciones éticas y sociales. El sector tecnológico deberá pivotar de la simple expansión a la optimización, de la cantidad a la calidad, y de la escala a la inteligencia real y sostenible. El verdadero desafío, y la próxima gran oportunidad, será construir sistemas de IA que no solo sean más grandes, sino fundamentalmente más inteligentes, más eficientes y más responsables.

IA Ley de Moore Límites tecnológicos Sostenibilidad IA