Imaginemos un futuro no tan lejano, apenas en 2030. Un futuro donde la inteligencia artificial (IA), esa fuerza transformadora que ya está redefiniendo nuestro mundo, demande una cantidad de energía equivalente a la producción de un centenar de reactores nucleares. Esta no es una hipótesis de ciencia ficción, sino una proyección alarmante que nos obliga a pausar y reflexionar sobre las profundas implicaciones de la era de la IA. El asombroso crecimiento de la capacidad computacional necesaria para entrenar y ejecutar modelos de IA cada vez más complejos está desatando una demanda energética sin precedentes, que ya empieza a poner a prueba nuestra infraestructura global. La promesa de la IA para la humanidad es inmensa, pero su huella de carbono y el estrés que impondrá a las redes eléctricas no pueden ser ignorados. Estamos ante una encrucijada energética que no solo determinará el ritmo de la innovación tecnológica, sino también el futuro de nuestro planeta. ¿Cómo afrontaremos este desafío colosal? ¿Quiénes serán los protagonistas que se beneficiarán y ayudarán a forjar un camino sostenible en esta nueva era de consumo energético?

La magnitud del desafío energético de la IA

La proyección de que la IA consumirá tanta energía como un centenar de reactores para 2030 es, cuanto menos, impactante. Para ponerlo en perspectiva, un reactor nuclear moderno puede generar alrededor de 1 GW de electricidad. Cien de ellos representarían 100 GW de capacidad instalada, una cifra comparable a la demanda eléctrica de países enteros. Este incremento exponencial en el consumo de energía se debe a varios factores intrínsecos al desarrollo y la implementación de la IA.

En primer lugar, el entrenamiento de modelos de IA de vanguardia es un proceso extraordinariamente intensivo en computación y, por ende, en energía. Los modelos de lenguaje grandes (LLM, por sus siglas en inglés), como los que impulsan ChatGPT o Gemini, requieren miles de millones de parámetros y la ejecución de billones de operaciones de coma flotante. El proceso de entrenamiento de un solo modelo puede consumir la misma energía que cientos de hogares durante un año entero. A medida que estos modelos se hacen más grandes y más capaces, su apetito energético crece de forma no lineal.

En segundo lugar, la inferencia, es decir, el uso de estos modelos una vez entrenados para generar respuestas o realizar tareas, aunque menos intensiva que el entrenamiento, se realiza a una escala masiva. Cada vez que interactuamos con un chatbot, usamos un motor de búsqueda mejorado por IA, o nos beneficiamos de la IA en aplicaciones cotidianas, estamos contribuyendo a esa demanda energética. Con miles de millones de usuarios potenciales y la integración de la IA en casi todos los aspectos de nuestra vida digital, la acumulación de estas pequeñas inferencias se convierte en una carga energética monumental.

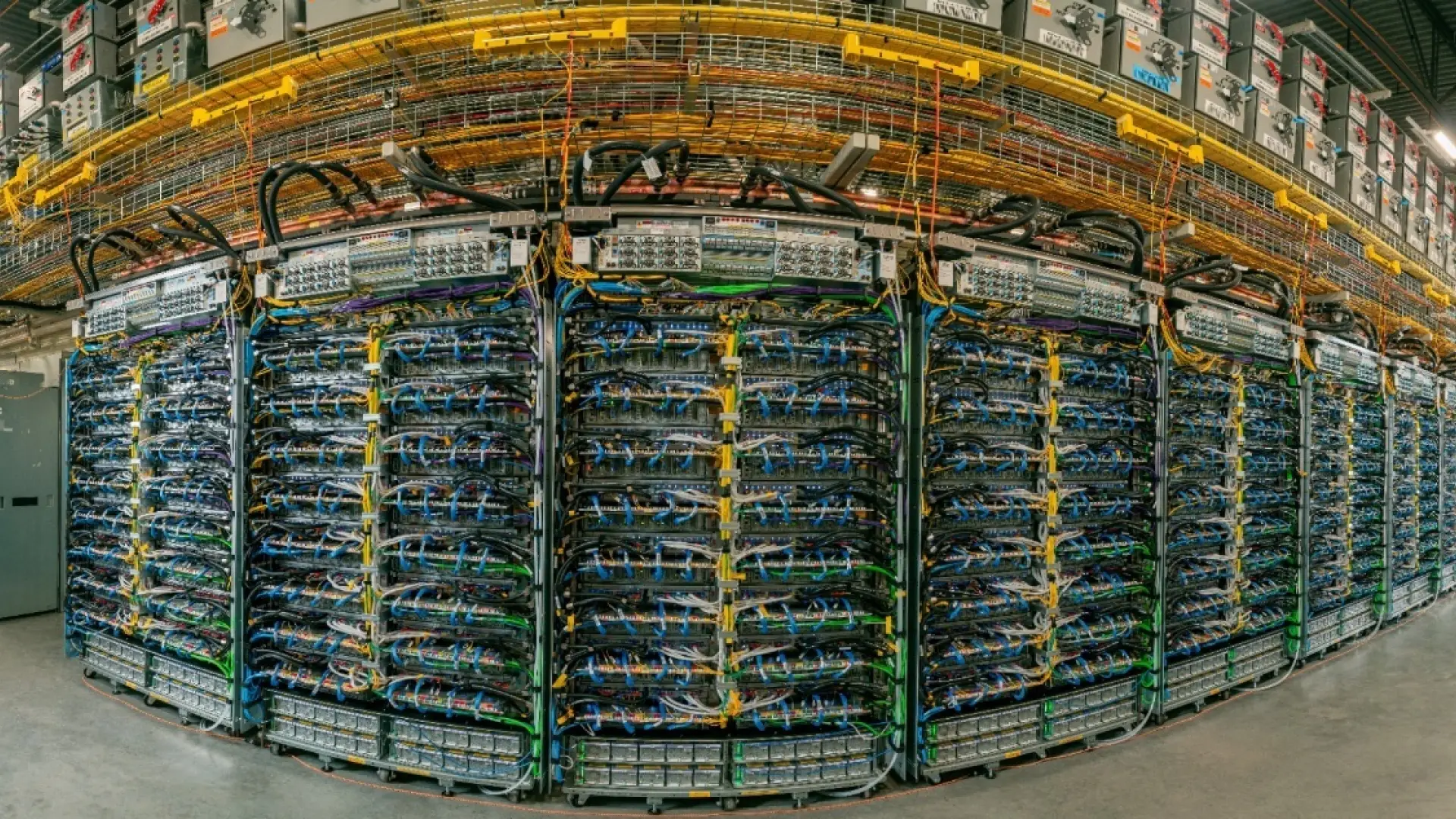

Finalmente, los centros de datos, las infraestructuras físicas donde residen los servidores que albergan estos modelos de IA, son los principales consumidores de energía. No solo se trata de la electricidad necesaria para alimentar las unidades de procesamiento gráfico (GPU) y otros chips especializados, sino también de la enorme cantidad de energía que se requiere para refrigerar estos equipos, que generan una gran cantidad de calor. La eficiencia energética de los centros de datos ha mejorado, pero la escala del crecimiento de la IA amenaza con superar cualquier ganancia en eficiencia. La demanda de energía ya está provocando interrupciones y retrasos en la construcción de nuevos centros de datos en algunas regiones, y está poniendo a prueba la capacidad de las redes eléctricas existentes.

Desde mi punto de vista, la sociedad apenas está comenzando a comprender la magnitud de esta huella energética. Si no abordamos este problema de manera proactiva, corremos el riesgo de que la promesa de la IA se vea empañada por su impacto ambiental y por la inestabilidad de las redes eléctricas. Es una carrera contra el tiempo, donde la innovación en eficiencia y en generación de energía limpia será crucial.

Impacto en la infraestructura energética global

La demanda energética de la IA no es solo un problema de números; tiene consecuencias directas y tangibles en la infraestructura energética global. Las redes eléctricas, diseñadas para patrones de consumo relativamente predecibles, se enfrentan ahora a un nuevo y masivo consumidor que crece a un ritmo vertiginoso.

Uno de los impactos más inmediatos es la tensión sobre la capacidad de generación existente. Muchos países ya luchan por satisfacer su demanda energética actual, y la adición de una carga equivalente a cien reactores requerirá una inversión masiva en nuevas plantas de energía o una aceleración drástica en la implementación de fuentes renovables. Sin una planificación adecuada, esto podría llevar a un aumento de la dependencia de combustibles fósiles, contradiciendo los objetivos climáticos globales, o a la proliferación de centrales nucleares, que si bien son bajas en carbono, conllevan otros debates y desafíos.

Además, la infraestructura de transmisión y distribución también se verá sometida a una presión inmensa. Los centros de datos de IA tienden a agruparse en ciertas regiones debido a la disponibilidad de talento, conectividad o incentivos. Esto crea "puntos calientes" de demanda que pueden sobrecargar las subestaciones y las líneas de transmisión locales, requiriendo mejoras significativas y costosas en la red. Ya estamos viendo cómo empresas como Google, Microsoft y Amazon están buscando ubicaciones con abundante energía renovable y capacidad de red disponible para sus futuras expansiones. Este factor es tan crítico que está influyendo directamente en las decisiones de inversión y ubicación de las principales empresas tecnológicas. Para entender mejor la situación, este informe de la Agencia Internacional de la Energía (IEA) sobre la demanda eléctrica global puede ser muy esclarecedor: Informe del Mercado Eléctrico 2024 de la IEA.

La volatilidad en los precios de la energía y la posibilidad de apagones regionales son riesgos reales si no se gestiona esta transición con astucia. La carrera por la energía para la IA no solo es tecnológica, sino también geopolítica, ya que los países con acceso a fuentes de energía fiables y sostenibles tendrán una ventaja estratégica.

Los ganadores de la era del consumo energético de la IA

Ante este panorama, es inevitable preguntarse quiénes se beneficiarán de esta megatendencia. Identifico varios sectores y actores que están posicionados para emerger como los principales ganadores en la era del consumo energético de la IA.

Proveedores de energía renovable y nuclear

Sin duda, los productores de energía renovable (solar, eólica, geotérmica, hidroeléctrica) se encuentran en una posición privilegiada. La IA necesita energía constante y, cada vez más, energía "verde" para cumplir con los objetivos de sostenibilidad de las grandes empresas tecnológicas. Aquellas compañías que puedan ofrecer contratos de compra de energía a largo plazo (PPAs) de fuentes renovables a gran escala serán cruciales. Países con vastos recursos eólicos (como Dinamarca o el Reino Unido) o solares (España, Estados Unidos, Australia) podrían atraer inversiones masivas en centros de datos. La energía nuclear, con su capacidad de generación de carga base y bajas emisiones de carbono, también verá un resurgimiento del interés, a pesar de sus desafíos inherentes. Empresas como Iberdrola, Ørsted o NextEra Energy, con grandes carteras de proyectos renovables, están en una excelente posición.

Empresas de infraestructura eléctrica y almacenamiento

La modernización y expansión de las redes eléctricas es imperativa. Esto beneficiará a los fabricantes de transformadores, equipos de conmutación, cables de alta tensión y sistemas de gestión de red inteligente. Empresas como Siemens Energy, ABB o Schneider Electric jugarán un papel vital. Además, las soluciones de almacenamiento de energía (baterías de iones de litio, almacenamiento de energía bombeada) se volverán esenciales para garantizar la estabilidad de la red, especialmente con la creciente incorporación de fuentes renovables intermitentes. Compañías que innoven en este campo, desde fabricantes de baterías hasta desarrolladores de proyectos de almacenamiento a escala de red, verán un crecimiento significativo. Un ejemplo interesante de innovaciones en este campo lo ofrece Form Energy con sus baterías de hierro-aire de larga duración.

Desarrolladores de hardware de IA eficiente

La eficiencia energética de los chips de IA es un campo de batalla clave. Las empresas que puedan diseñar y fabricar procesadores (GPU, NPU, ASIC) que ofrezcan mayor rendimiento por vatio serán invaluables. Líderes actuales como Nvidia, pero también sus competidores como AMD e Intel, están invirtiendo fuertemente en esta área. Las innovaciones en arquitectura de chips, materiales y procesos de fabricación que permitan un menor consumo de energía sin sacrificar la potencia serán los pilares de esta eficiencia. Es fundamental que el hardware no solo sea potente, sino también 'verde'.

Innovadores en software y algoritmos de IA

No toda la solución reside en el hardware. Los investigadores y desarrolladores que logren crear modelos de IA más eficientes desde el punto de vista algorítmico también serán grandes ganadores. Esto incluye técnicas como la cuantificación (reducir la precisión numérica de los cálculos), la poda (eliminar conexiones neuronales redundantes), la arquitectura de modelos más compacta y los algoritmos de entrenamiento que convergen más rápidamente. Empresas que puedan ofrecer "IA eficiente en energía" como un servicio o producto diferenciador tendrán una ventaja competitiva significativa. La optimización del software para reducir la huella energética es un campo de investigación vibrante, y algunos resultados prometedores pueden encontrarse en publicaciones académicas. Un buen punto de partida podría ser el trabajo de Google DeepMind en eficiencia, como se detalla en sus publicaciones en Google DeepMind Blog.

Países con políticas energéticas proactivas

Finalmente, los países que adopten políticas energéticas proactivas, incentivando la inversión en energías limpias, facilitando la construcción de infraestructura y ofreciendo estabilidad regulatoria, serán destinos atractivos para la inversión en centros de datos. Aquellos que puedan garantizar un suministro eléctrico abundante, asequible y sostenible se posicionarán como líderes en la economía de la IA. La planificación a largo plazo y la voluntad política para invertir en la transición energética serán tan importantes como los recursos naturales. Considero que la colaboración internacional en este ámbito es tan crucial como la competencia.

Estrategias y soluciones para mitigar el consumo

Mitigar el inmenso consumo energético de la IA requerirá una estrategia multifacética que combine avances tecnológicos, planificación de infraestructura y políticas regulatorias.

Una de las áreas más prometedoras es la eficiencia energética a nivel de hardware y software. La optimización de chips, como mencionamos, es fundamental. Pero también lo son las innovaciones en sistemas de refrigeración para centros de datos. La refrigeración líquida directa al chip, la inmersión en líquidos dieléctricos, y el uso de técnicas de "free cooling" (aprovechando temperaturas ambientales bajas) pueden reducir drásticamente la energía requerida para disipar el calor. El diseño de centros de datos eficientes, con una gestión inteligente de la energía y el calor, es una batalla constante.

A nivel de software, el desarrollo de modelos de IA más pequeños y eficientes es una prioridad. No todos los problemas requieren un modelo del tamaño de un LLM gigante. La "destilación de conocimiento" (transferir el conocimiento de un modelo grande a uno más pequeño), el uso de arquitecturas de modelos más ligeras y la especialización de modelos para tareas específicas pueden reducir significativamente los requisitos computacionales para la inferencia. Las técnicas de compresión de modelos y la investigación en algoritmos de aprendizaje federado y edge AI también contribuirán a esta eficiencia, llevando la computación más cerca de la fuente de datos y reduciendo la necesidad de enviar todo a grandes centros de datos.

Otra estrategia clave es la ubicación estratégica de centros de datos. Colocarlos cerca de grandes fuentes de energía renovable (parques eólicos o solares) o en regiones con climas fríos naturales para minimizar la refrigeración es una tendencia creciente. Islandia y los países nórdicos, con su energía geotérmica e hidroeléctrica abundante y temperaturas bajas, ya están atrayendo a operadores de centros de datos. Esto no solo reduce la huella de carbono, sino que también puede disminuir los costos operativos a largo plazo.

Finalmente, las políticas y regulaciones gubernamentales tienen un papel crucial. Los incentivos fiscales para la inversión en energías renovables y en infraestructura de centros de datos eficientes, los estándares de eficiencia para el hardware de IA, y la financiación para la investigación en tecnologías de IA de bajo consumo energético, son palancas que los gobiernos pueden activar. Una visión a largo plazo y una colaboración público-privada serán esenciales para navegar este desafío. La Unión Europea, por ejemplo, está discutiendo activamente la regulación del consumo energético de la IA en sus nuevas leyes. Puede encontrar más información sobre las iniciativas de la UE aquí: Estrategia de la Comisión Europea para la IA.

En mi opinión, la transición energética de la IA no es una opción, sino una necesidad imperante. No podemos permitir que el progreso tecnológico se traduzca en una crisis climática o energética. La oportunidad de innovar en soluciones sostenibles es tan grande como el desafío mismo. Aquellos que abracen la sostenibilidad como un principio de diseño para la IA serán los verdaderos visionarios.

Conclusión

La proyección de que la IA consumirá la energía de cien reactores para 2030 subraya una realidad ineludible: la tecnología, por más avanzada que sea, no opera en un vacío. Su crecimiento y expansión tienen implicaciones profundas para nuestro planeta y nuestra infraestructura. Hemos explorado cómo el entrenamiento y la inferencia de modelos, junto con la expansión de los centros de datos, están impulsando esta demanda, y cómo esto ejerce una presión sin precedentes sobre las redes eléctricas globales.

Sin embargo, este desafío monumental también abre puertas a una nueva era de innovación y oportunidad. Los proveedores de energía renovable, los desarrolladores de infraestructura eléctrica, los fabricantes de hardware eficiente, los innovadores en algoritmos de IA y las naciones con políticas energéticas visionarias están posicionados para liderar esta transformación. La clave residirá en la capacidad de la humanidad para equilibrar la ambición tecnológica con una profunda responsabilidad ambiental. La IA tiene el potencial de resolver algunos de los problemas más complejos del mundo, pero solo si logramos garantizar que su propia existencia sea sostenible. El camino hacia 2030 no solo definirá el futuro de la inteligencia artificial, sino también el futuro de nuestra relación con la energía y con nuestro hogar planetario. Es una llamada a la acción para ingenieros, científicos, legisladores y ciudadanos por igual.

Inteligencia Artificial Consumo Energético Energías Renovables Centros de Datos