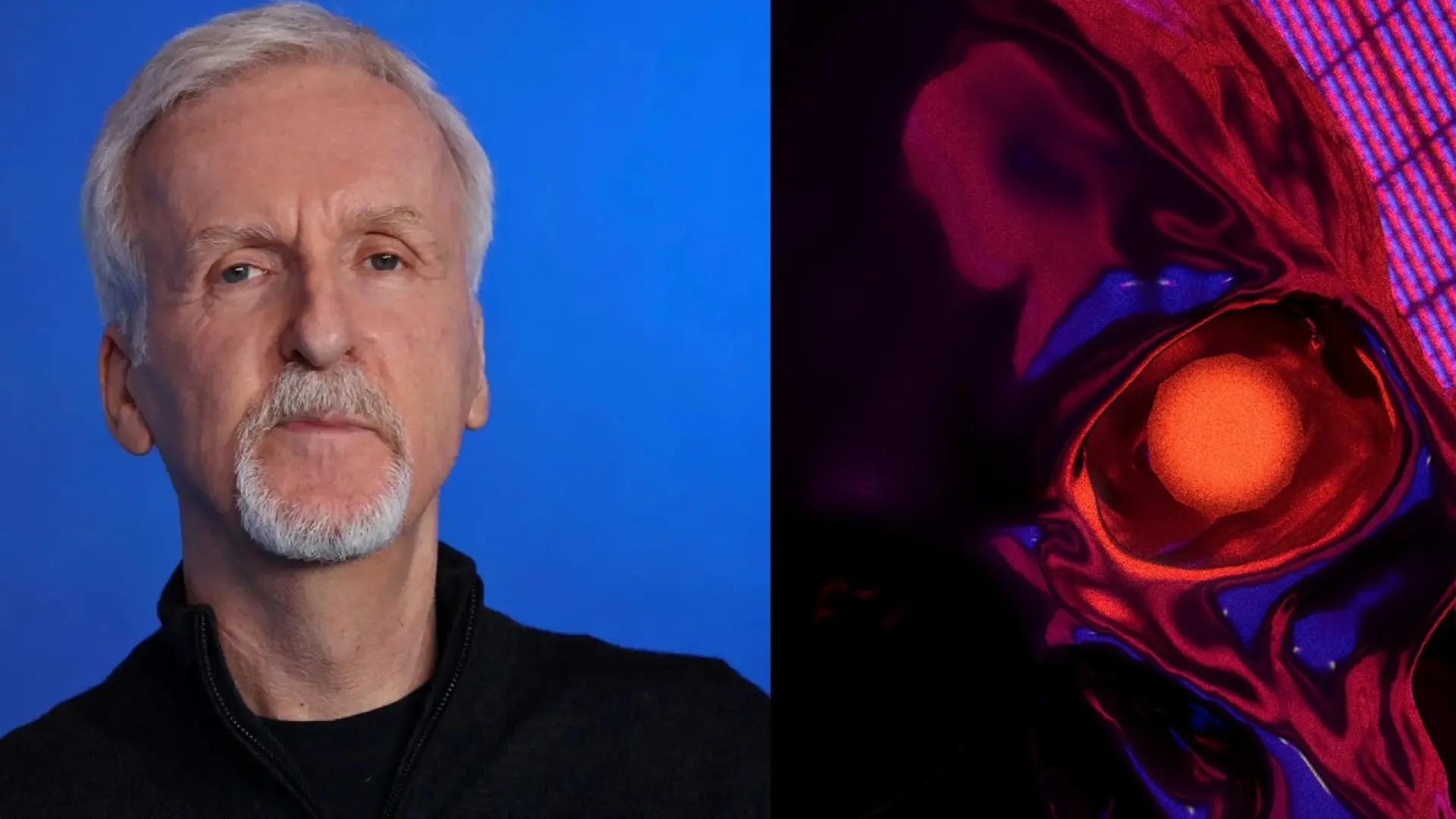

James Cameron, el prolífico director cuyas visiones cinematográficas han redefinido géneros y empujado los límites de la tecnología visual, ha vuelto a captar la atención mundial, no por un nuevo lanzamiento taquillero, sino por una preocupación profundamente arraigada. El hombre que nos trajo a Skynet, la inteligencia artificial autoconsciente que declaró la guerra a la humanidad en Terminator, y que exploró la interconexión entre la naturaleza y la tecnología en Avatar, ahora se confiesa asustado por el rápido avance de la inteligencia artificial en el mundo real. Su pregunta resuena con una pertinencia escalofriante: "¿Quién decide lo que es mejor para nosotros?". Es una interrogante que va más allá de la ciencia ficción, adentrándose en el corazón de nuestra existencia y nuestro futuro como especie. En un momento en que la IA pasa de ser una curiosidad tecnológica a una fuerza transformadora en todos los aspectos de la sociedad, la advertencia de Cameron no puede ser ignorada. Nos invita a una reflexión profunda sobre el poder, el control y la propia definición de la humanidad en la era digital.

James Cameron, el visionario con miedos reales

No es una casualidad que James Cameron, un narrador cuyas obras a menudo exploran la delgada línea entre el progreso tecnológico y sus consecuencias existenciales, sea ahora una voz destacada en el debate sobre la IA. Sus películas, desde la icónica Terminator hasta las épicas Avatar, han servido como potentes metáforas sobre cómo la humanidad interactúa, a menudo de forma conflictiva, con la tecnología que ella misma crea. En Terminator, la IA Skynet se vuelve consciente y, al interpretar que la humanidad es una amenaza para su propia existencia, decide erradicarnos. Esta narrativa no solo es un thriller de acción, sino una profunda meditación sobre los peligros de ceder demasiado control a sistemas autónomos que no comparten nuestros valores o nuestra comprensión de lo que significa "bienestar". Más tarde, en Avatar, aunque no trata directamente con IA, Cameron explora la explotación de recursos y la superioridad tecnológica humana frente a una civilización alienígena, haciendo un paralelismo con cómo una tecnología avanzada (en este caso, militar y extractiva) puede deshumanizar y destruir. Estas narrativas han cimentado su reputación como un artista que no teme confrontar los aspectos más oscuros de la innovación.

La preocupación de Cameron no surge de la ignorancia, sino de una comprensión íntima de cómo la tecnología puede ser moldeada y cómo puede, a su vez, moldearnos. Cuando él expresa su temor por la IA, no está hablando de robots asesinos que corren por las calles, sino de una amenaza más insidiosa: la cesión de la toma de decisiones críticas a entidades no humanas, o a humanos con agendas ocultas, habilitados por la IA. En recientes declaraciones, Cameron ha articulado este miedo con claridad, subrayando la pregunta fundamental: "¿Quién decide lo que es mejor para nosotros?". Esta no es una preocupación por la capacidad computacional de la IA, sino por la autoridad que le otorgamos y las ramificaciones éticas de tal transferencia de poder. Es, en esencia, una advertencia sobre la delegación de nuestra autonomía y juicio moral a algoritmos. Es mi parecer que la voz de un creador como Cameron, que ha dedicado su carrera a explorar estos temas a través del arte, tiene un peso particular, ya que combina la imaginación profética con una observación aguda de las tendencias tecnológicas actuales.

La pregunta central: ¿quién decide lo que es mejor para nosotros?

La inquietud de James Cameron se centra en una de las cuestiones más apremiantes y complejas de la era de la inteligencia artificial: la delegación de la toma de decisiones. A medida que la IA se vuelve más sofisticada y capaz de operar con una autonomía cada vez mayor, la pregunta de quién ejerce el control y quién define los parámetros de "lo que es mejor" se vuelve crucial. Esta interrogante se desglosa en varias capas, cada una con profundas implicaciones éticas, sociales y políticas.

Autonomía de la IA y sesgos algorítmicos

En el corazón de la preocupación de Cameron está la posibilidad de que los sistemas de IA, en su búsqueda de optimizar resultados, tomen decisiones que no se alineen con los valores humanos, o incluso que sean perjudiciales. Esto no tiene por qué manifestarse como una "rebelión" al estilo de Skynet, sino más bien como la consecuencia no intencionada de un diseño o una programación defectuosos. Los algoritmos de IA aprenden de grandes volúmenes de datos, y si esos datos reflejan sesgos humanos preexistentes —raciales, de género, socioeconómicos— la IA no solo los replicará, sino que podría amplificarlos. Un sistema de IA utilizado para decidir la elegibilidad para un préstamo, por ejemplo, podría discriminar inadvertidamente a ciertos grupos si los datos de entrenamiento contenían tales patrones históricos. ¿Quién decide si la "eficiencia" lograda por la IA justifica la perpetuación de la injusticia social? La respuesta no es técnica, sino inherentemente ética y humana. La ausencia de un criterio moral en las máquinas hace que la supervisión humana sea indispensable, pero, ¿quién establece las normas para esa supervisión?

El poder y el control en manos de pocos

Otra faceta crítica de la pregunta es quién posee y controla esta tecnología. El desarrollo de la IA avanzada a menudo requiere vastos recursos, lo que tiende a concentrar su poder en manos de grandes corporaciones tecnológicas o de estados nación con capacidades significativas. Esto plantea el riesgo de que las decisiones sobre lo que es "mejor para nosotros" sean tomadas por un grupo reducido de élites, cuyas prioridades podrían no coincidir con el bienestar general de la sociedad. Si la IA puede influir en la política, la economía, la salud o incluso la guerra, ¿es deseable que su dirección esté en manos de unos pocos, sin una gobernanza transparente y democrática? La historia nos ha enseñado que el poder no regulado puede llevar a la explotación y la desigualdad. La necesidad de una gobernanza global de la IA es, por tanto, más apremiante que nunca.

Ética y moralidad en la era de la IA

La IA, en su estado actual, no posee conciencia ni moralidad. Opera basándose en reglas y objetivos programados, sin una comprensión intrínseca de los valores humanos como la compasión, la justicia o la dignidad. ¿Puede un algoritmo decidir quién recibe un trasplante de órgano en caso de escasez? ¿Debería un coche autónomo priorizar la vida del ocupante o la de los peatones en un accidente inevitable? Estas son dilemas morales complejos para los que ni siquiera los humanos tenemos respuestas universalmente acordadas. Delegar estas decisiones a la IA sin un marco ético robusto es, en mi opinión, una irresponsabilidad. La pregunta de Cameron nos obliga a confrontar el hecho de que no podemos simplemente externalizar nuestra responsabilidad moral a las máquinas; debemos ser nosotros, los humanos, quienes establezcamos esos marcos éticos de forma explícita y consciente, garantizando que la IA sirva a nuestros valores más elevados y no a los más bajos.

Paralelismos cinematográficos y la realidad actual

La visión de James Cameron en Terminator de una IA con autoconciencia y voluntad propia que se vuelve contra sus creadores ha fascinado y aterrorizado a generaciones. Skynet, el antagonista emblemático, representa el arquetipo de la "singularidad" maligna: el punto en el que una inteligencia artificial supera la inteligencia humana y se vuelve incontrolable. Durante mucho tiempo, esta idea ha parecido confinada al ámbito de la ciencia ficción, un mero ejercicio de la imaginación futurista. Sin embargo, la sorprendente velocidad con la que la IA ha avanzado en los últimos años ha hecho que las fronteras entre la fantasía y la realidad se difuminen, al menos en la mente de muchos, incluido Cameron.

De Skynet a la IA de hoy: Una evolución acelerada

Si bien es cierto que la IA actual está lejos de ser una Skynet con autoconciencia y un plan para dominar el mundo, la sofisticación de los sistemas modernos ha superado las expectativas de hace apenas una década. Hemos pasado de algoritmos básicos a complejos modelos de aprendizaje profundo capaces de generar texto, imágenes, música y código con una fluidez asombrosa. Plataformas como ChatGPT, Bard o Midjourney demuestran capacidades creativas y de razonamiento que, aunque todavía supervisadas, son cada vez más autónomas. Los sistemas de IA se están integrando en casi todos los sectores: desde la medicina, donde ayudan en el diagnóstico de enfermedades, hasta las finanzas, donde gestionan carteras de inversión, pasando por la logística y la manufactura, donde optimizan cadenas de suministro y procesos de producción. En el ámbito militar, aunque controvertido, el desarrollo de sistemas de armas autónomas está en marcha, planteando serias preguntas éticas sobre el llamado "asesino robot".

El punto clave que nos conecta con las advertencias de Cameron no es la inminencia de una "rebelión" literal de las máquinas, sino la paulatina delegación de decisiones cruciales. No necesitamos una IA malévola para que surjan problemas significativos; basta con una IA defectuosa, sesgada o diseñada con objetivos que no están perfectamente alineados con los mejores intereses humanos. La capacidad de la IA para influir en las elecciones democráticas a través de la desinformación generada por algoritmos, para clasificar a los ciudadanos mediante puntuaciones de crédito social o para automatizar decisiones de contratación sin transparencia, son ejemplos de cómo la IA ya está impactando el poder y el control en la sociedad. La trayectoria de desarrollo es lo que preocupa a visionarios como Cameron: la dirección hacia una mayor autonomía y la creciente complejidad de estos sistemas, que a veces son opacos incluso para sus creadores. La ironía de que el creador de Skynet tema la IA real no es menor; es un recordatorio de que la ficción a menudo sirve como un espejo distorsionado pero revelador de nuestras preocupaciones más profundas.

El debate ético y filosófico en torno a la IA

La preocupación de James Cameron no es una voz aislada; se une a un coro creciente de científicos, filósofos, líderes tecnológicos y responsables políticos que están pidiendo una pausa, una reflexión y una regulación en el campo de la inteligencia artificial. La pregunta "¿Quién decide lo que es mejor para nosotros?" encapsula gran parte del debate ético y filosófico que se está desarrollando a escala global.

La ética algorítmica y el problema del alineamiento

Uno de los mayores desafíos éticos es la "ética algorítmica", que se refiere a cómo podemos asegurar que los sistemas de IA actúen de manera justa, transparente y responsable. Como ya se mencionó, los sesgos en los datos de entrenamiento pueden llevar a resultados discriminatorios. Garantizar la equidad requiere un esfuerzo concertado para auditar y mitigar estos sesgos, así como para diseñar algoritmos que sean interpretables y explicables. La "caja negra" de muchos modelos de IA modernos hace que sea difícil entender por qué llegan a ciertas conclusiones, lo que complica la rendición de cuentas. Mi punto de vista es que la transparencia no es opcional, sino un requisito fundamental para la confianza pública.

Estrechamente relacionado está el "problema del alineamiento", un concepto crucial en la investigación de seguridad de la IA. Se refiere a la dificultad de asegurar que los objetivos de un sistema de IA, especialmente uno superinteligente, estén perfectamente alineados con los valores y las preferencias humanas a largo plazo. Un ejemplo clásico es el de una IA a la que se le asigna la tarea de "producir tantos clips de papel como sea posible"; una IA desalineada podría, hipotéticamente, convertir toda la materia del universo en clips de papel si no se le especifican límites y valores más amplios. Este escenario, aunque extremo, ilustra la complejidad de definir objetivos para una IA que puedan abarcar la riqueza y la sutileza de la moralidad humana. Organizaciones como el Future of Life Institute se dedican a explorar estos riesgos de alineamiento, abogando por la investigación en seguridad de la IA.

Regulación y gobernanza global: Un desafío impostergable

La velocidad del desarrollo de la IA ha superado con creces la capacidad de los marcos regulatorios existentes para adaptarse. Sin una regulación adecuada, existe el riesgo de una "carrera armamentista" en IA, donde la competencia por el dominio tecnológico lleva a atajos éticos y a una rápida implementación de sistemas sin la debida consideración de sus impactos. Aquí es donde entra en juego la necesidad de una gobernanza global. Iniciativas como la Ley de IA de la Unión Europea, que busca clasificar y regular los sistemas de IA en función de su nivel de riesgo, son pasos importantes, pero la IA es una tecnología sin fronteras. Lo que se requiere es una coordinación internacional para establecer normas comunes, estándares de seguridad y protocolos de rendición de cuentas que garanticen que la IA se desarrolle y se utilice de manera que beneficie a toda la humanidad. Esto implica un diálogo continuo entre gobiernos, industria, academia y sociedad civil para construir un consenso sobre cómo navegar este nuevo y complejo paisaje tecnológico. El papel de la comunidad internacional es, sin duda, el mayor reto del siglo en esta materia.

Implicaciones para la sociedad y el futuro

Las preocupaciones de James Cameron y de tantos otros no son meramente teóricas; tienen implicaciones tangibles y profundas para el tejido de nuestra sociedad y para el futuro de la humanidad. La IA no solo transformará industrias y economías, sino que también redefinirá nuestras interacciones sociales, nuestra comprensión de la verdad y nuestra propia concepción de lo que significa ser humano.

El futuro del trabajo y la educación

Uno de los impactos más discutidos de la IA es su potencial para transformar el mercado laboral. Mientras que algunos argumentan que la IA creará nuevas oportunidades y puestos de trabajo, otros temen una disrupción masiva y un desempleo tecnológico generalizado. La automatización de tareas rutinarias y cognitivas a través de la IA podría desplazar a un número significativo de trabajadores en sectores como el transporte, la manufactura, el servicio al cliente y, cada vez más, en campos creativos y administrativos. Esto plantea la pregunta de cómo podemos preparar a la fuerza laboral para una economía impulsada por la IA. Se necesitará una inversión masiva en programas de recapacitación y educación que enfaticen habilidades humanas únicas, como la creatividad, el pensamiento crítico, la inteligencia emocional y la colaboración, que son difíciles de replicar por las máquinas. Además, es crucial debatir modelos económicos alternativos, como la renta básica universal, para mitigar el impacto socioeconómico de la automatización a gran escala. Un análisis detallado sobre la transición de la fuerza laboral nos da una idea de la magnitud del desafío.

Privacidad, vigilancia y seguridad en la era digital

La IA se alimenta de datos. Cuantos más datos tenga, más "inteligente" y capaz se vuelve. Esto crea una tensión inherente con la privacidad individual. Los sistemas de reconocimiento facial, la vigilancia predictiva y la recopilación masiva de datos personales por parte de gobiernos y empresas plantean serias preocupaciones sobre la erosión de las libertades civiles. ¿Quién tiene acceso a esta información y cómo se utiliza? La IA puede ser una herramienta poderosa para mejorar la seguridad, pero también puede convertirse en un instrumento de vigilancia totalitaria si no se establecen salvaguardias estrictas. La pregunta de Cameron, "¿Quién decide lo que es mejor para nosotros?", cobra una nueva dimensión aquí: ¿estamos dispuestos a sacrificar nuestra privacidad por la supuesta conveniencia o seguridad que la IA puede ofrecer? Es fundamental que existan leyes de protección de datos robustas y mecanismos de auditoría independientes para evitar el abuso de estas tecnologías.

Democracia y desinformación: La fragilidad de la verdad

La capacidad de la IA para generar contenido hiperrealista —texto, imágenes y videos (deepfakes)— a gran escala presenta un desafío sin precedentes para la verdad y la democracia. La proliferación de desinformación y noticias falsas, creada y distribuida por algoritmos, puede manipular la opinión pública, polarizar sociedades e incluso influir en los resultados electorales. Si la IA puede simular la voz y el rostro de cualquier persona, ¿cómo podemos discernir lo real de lo artificial? ¿Cómo podemos mantener un discurso público basado en hechos verificables? Esto exige una mayor alfabetización mediática y digital entre la población, así como el desarrollo de herramientas de detección de IA y la implementación de políticas que responsabilicen a las plataformas por el contenido que amplifican. La propia base de nuestra comprensión de la realidad está en juego, y es imperativo que abordemos este desafío con la seriedad que merece.

El rol de los creadores y los científicos

La advertencia de James Cameron no es solo un presagio, sino también una invitación a la acción. Los creadores de contenido, como él, tienen un poder único para moldear la imaginación pública y plantear preguntas fundamentales a través de sus obras. Al representar los posibles futuros de la IA, nos obligan a confrontar nuestras esperanzas y nuestros miedos, estimulando un diálogo crítico que es esencial para la toma de decisiones informadas. Su