En una era donde la línea entre lo real y lo sintético se difumina a una velocidad vertiginosa, la capacidad de discernir el origen de una imagen se ha convertido en una habilidad crucial, no solo para expertos, sino para el usuario promedio. La proliferación de herramientas de inteligencia artificial generativa ha desatado una ola de creatividad sin precedentes, pero también ha abierto la puerta a desafíos significativos en cuanto a la autenticidad y la verdad. Ante este panorama, Google ha dado un paso fundamental, integrando en su modelo de IA más avanzado, Gemini, la facultad de identificar si una imagen ha sido creada por sus propias inteligencias artificiales. Esta funcionalidad, que a primera vista podría parecer una característica más, representa un avance considerable en la lucha por mantener la confianza en el ecosistema digital. No se trata simplemente de una herramienta tecnológica; es un intento de restaurar una parte de la credibilidad que se ha visto erosionada por la facilidad con la que se pueden generar y difundir imágenes fotorrealistas de eventos o situaciones inexistentes. La capacidad de Gemini de actuar como un faro de verdad en el vasto océano de contenido digital es una noticia que, en mi opinión, llega en el momento justo, aunque con ciertas particularidades que es importante entender a fondo.

El auge de la inteligencia artificial generativa y sus desafíos

La última década ha sido testigo de una explosión en el campo de la inteligencia artificial, con un énfasis particular en la generación de contenido. Modelos como DALL-E, Midjourney y Stable Diffusion han democratizado la creación visual, permitiendo a cualquier persona, sin conocimientos artísticos o técnicos avanzados, generar imágenes impresionantes a partir de simples descripciones de texto. Desde paisajes oníricos hasta retratos hiperrealistas, las posibilidades creativas son prácticamente ilimitadas. Esta revolución ha transformado sectores como el diseño gráfico, la publicidad, el entretenimiento y la educación, abriendo nuevas vías para la expresión y la eficiencia. Las empresas pueden generar prototipos visuales en minutos, los artistas pueden explorar nuevas dimensiones creativas y los comunicadores pueden ilustrar ideas complejas con facilidad. Es un cambio de paradigma que promete redefinir la interacción humana con la creatividad y el conocimiento.

Sin embargo, cada gran avance tecnológico trae consigo su propio conjunto de desafíos. La facilidad con la que se pueden generar imágenes realistas plantea serias preocupaciones sobre la desinformación y los "deepfakes". En un mundo donde las noticias falsas pueden propagarse más rápido que las verdaderas, la capacidad de crear imágenes convincentes de eventos que nunca ocurrieron o de personas diciendo cosas que nunca dijeron tiene implicaciones profundas para la política, la sociedad y la confianza pública. La manipulación de imágenes no es un fenómeno nuevo, pero la escala, la calidad y la accesibilidad de las herramientas de IA generativa han elevado el riesgo a un nivel sin precedentes. La autenticidad se ha convertido en una moneda de cambio preciada, y la capacidad de distinguir lo real de lo artificial es más vital que nunca. La sociedad, en general, aún está adaptándose a esta nueva realidad, y herramientas como la que integra Gemini son esenciales para navegar este complejo panorama.

Gemini, el asistente multimodal de Google

Google Gemini es la respuesta de la compañía a la próxima generación de modelos de inteligencia artificial: un modelo multimodal diseñado para comprender, operar y combinar diferentes tipos de información, incluyendo texto, código, audio, imagen y vídeo. Lanzado como una de las piedras angulares de la estrategia de IA de Google, Gemini se ha posicionado como una IA flexible y potente, capaz de adaptarse a una amplia gama de tareas y plataformas, desde centros de datos hasta dispositivos móviles. Su arquitectura permite procesar y razonar sobre información compleja de múltiples modalidades de forma simultánea, lo que le otorga una ventaja significativa sobre los modelos predecesores que se especializaban en una única modalidad. Esta capacidad multimodal es lo que permite a Gemini no solo generar texto coherente, sino también analizar imágenes, entender comandos de voz y, crucialmente, identificar patrones específicos incrustados dentro de los archivos visuales.

La integración de la función de detección de imágenes generadas por IA dentro de Gemini es, en mi opinión, una extensión lógica de su naturaleza multimodal. Si Gemini puede "ver" y "entender" lo que hay en una imagen para responder preguntas o generar descripciones, tiene sentido que también pueda "ver" y "entender" los metadatos o las "marcas" que indican su origen. Esta capacidad lo convierte en más que un simple generador de contenido o un asistente; lo eleva a la categoría de un guardián de la autenticidad digital, al menos dentro del ecosistema de Google. Es un movimiento estratégico que subraya la visión de Google de una IA responsable y útil, no solo en la creación, sino también en la verificación de la información. Para profundizar en el funcionamiento general de Gemini, se puede consultar la información en la página oficial de Google AI: Introducción a Gemini.

La nueva función: detección de imágenes generadas por IA de Google

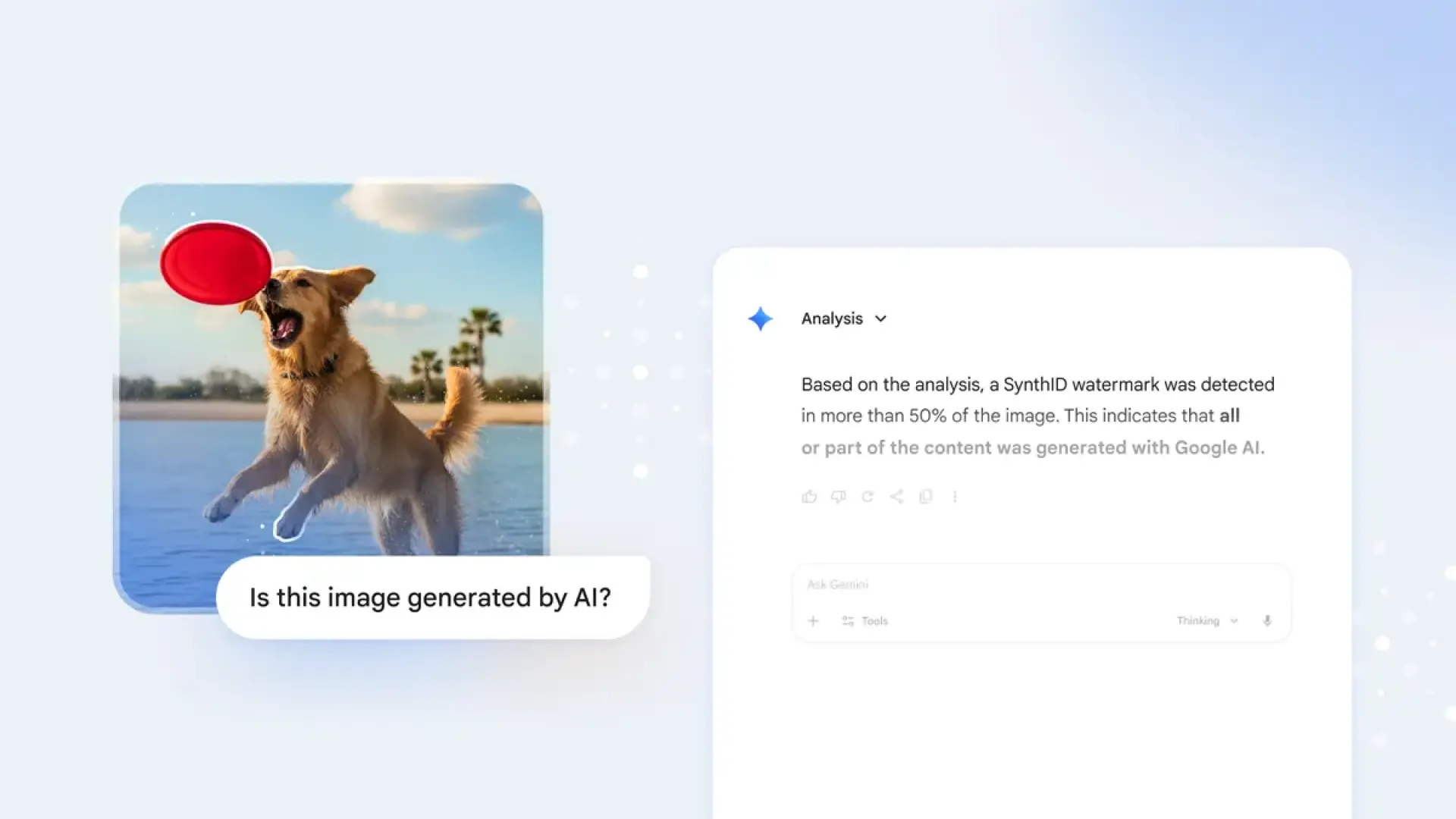

La flamante capacidad de Gemini permite a los usuarios preguntar directamente al modelo si una imagen que están visualizando ha sido creada por alguna de las inteligencias artificiales de Google. Cuando se le presenta una imagen, Gemini puede analizarla y proporcionar una respuesta con un cierto grado de confianza sobre su origen artificial. Es importante recalcar la naturaleza específica de esta funcionalidad: está diseñada para detectar imágenes generadas por la IA de Google. Esto significa que el sistema puede identificar si una imagen proviene de herramientas como Imagen, el modelo generativo de imágenes de Google, o de otras aplicaciones que utilizan tecnologías de IA similares desarrolladas internamente. Esta limitación, aunque significativa, no resta valor a la iniciativa, pero sí define su alcance actual.

Es fundamental entender qué no hace esta función. No puede identificar imágenes generadas por otras inteligencias artificiales de terceros, como DALL-E, Midjourney, Stable Diffusion, u otros modelos de código abierto o comerciales. Tampoco está diseñada para detectar imágenes que han sido manipuladas o alteradas por software de edición convencional por parte de un ser humano. Estas distinciones son cruciales para establecer expectativas realistas sobre la utilidad de la herramienta. La razón detrás de esta especificidad radica en la tecnología subyacente que Google ha implementado, conocida como SynthID. Al tener control sobre sus propios modelos generativos, Google puede incrustar una "firma" única en cada imagen que estos modelos producen, lo que facilita su posterior detección. Este enfoque de "sello de origen" es mucho más fiable que intentar inferir el origen de una imagen basándose únicamente en sus características visuales, que pueden ser fácilmente alteradas. Es, en esencia, una medida de autorregulación y responsabilidad por parte de Google, lo cual me parece un paso ético muy acertado. Para más detalles sobre la lucha contra la desinformación con IA, este artículo puede ser útil: Tecnología contra la desinformación.

¿Cómo funciona la detección de la IA de Google?

La magia detrás de la capacidad de Gemini para identificar imágenes generadas por la IA de Google reside en una combinación de tecnología de marca de agua digital y las avanzadas capacidades de análisis de Gemini. Este sistema está diseñado para ser robusto y relativamente resistente a las manipulaciones comunes.

Marca de agua digital invisible: SynthID

El núcleo de esta funcionalidad es una tecnología desarrollada por Google DeepMind llamada SynthID. A diferencia de las marcas de agua visibles que se superponen en una imagen para indicar su origen o proteger derechos de autor, SynthID utiliza una marca de agua digital "invisible" o imperceptible al ojo humano. Cuando un modelo de IA de Google genera una imagen, SynthID incrusta directamente en los píxeles de esa imagen un patrón sutil, una especie de "firma" digital única. Esta firma está diseñada para ser intrínsecamente parte de la imagen, no un añadido superficial. Se integra de tal manera que es extremadamente difícil de detectar o eliminar sin degradar significativamente la calidad de la imagen original.

Lo más impresionante de SynthID es su resiliencia. Google ha diseñado esta marca de agua para que persista incluso después de que la imagen sufra diversas transformaciones. Esto incluye acciones comunes como cambiar el tamaño, recortar, comprimir (por ejemplo, al subirla a redes sociales), aplicar filtros, ajustar el brillo o el contraste, e incluso convertirlas a diferentes formatos de archivo. La marca de agua se mantiene lo suficientemente intacta como para que un sistema de detección pueda identificarla. Es un equilibrio delicado entre la invisibilidad y la robustez, y representa un avance significativo en la autenticación de contenido digital. La meta es que, independientemente de cómo se comparta o modifique una imagen generada por IA de Google, su origen pueda ser rastreado. Puedes aprender más sobre SynthID en el blog de Google DeepMind: SynthID de Google DeepMind.

El papel de Gemini en la identificación

Una vez que una imagen con la marca de agua de SynthID se presenta a Gemini, el modelo entra en acción. Utilizando sus capacidades de análisis multimodal, Gemini examina la imagen en busca de estos patrones sutiles incrustados por SynthID. No está simplemente buscando metadatos EXIF (que pueden ser fácilmente eliminados o alterados), sino que está analizando la estructura profunda de los píxeles de la imagen.

El proceso es algo similar a cómo un experto forense podría buscar huellas dactilares o patrones específicos que un ojo inexperto pasaría por alto. Gemini ha sido entrenado para reconocer las firmas de SynthID, incluso cuando están ligeramente degradadas o modificadas. Una vez que la imagen es procesada, Gemini proporciona una respuesta clara al usuario. Esta respuesta puede indicar con un alto grado de confianza si la imagen fue generada por la IA de Google, si no tiene indicios de serlo, o si la confianza es baja debido a posibles manipulaciones excesivas de la imagen. La precisión y la velocidad de este proceso son fundamentales para su utilidad en el mundo real, donde las decisiones sobre la autenticidad a menudo deben tomarse rápidamente. Esta integración hace que la verificación sea accesible y fácil de usar para cualquier persona que interactúe con Gemini, democratizando la detección de IA en un nivel práctico.

Implicaciones y el futuro de la autenticidad digital

La integración de la detección de imágenes generadas por IA en Gemini es más que una simple característica; es un hito con amplias implicaciones para el futuro de la autenticidad digital y la gestión de la información. Marca un precedente importante y plantea interrogantes sobre la dirección en la que se moverá la industria de la IA en los próximos años.

Combatiendo la desinformación

Una de las implicaciones más directas y vitales de esta tecnología es su papel en la lucha contra la desinformación. En un panorama mediático saturado de contenido, donde la proliferación de imágenes falsas puede influir en la opinión pública, manipular elecciones o incitar al odio, tener una herramienta confiable para identificar el origen artificial de ciertas imágenes es invaluable. Aunque limitada a las creaciones de Google, esta funcionalidad puede ayudar a educar a los usuarios a ser más críticos con el contenido que consumen. Si una imagen viral resulta haber sido generada por la IA de Google, Gemini puede proporcionar esa información, alertando al usuario sobre su naturaleza no fotorrealista. Esto es particularmente importante en contextos como las noticias, las redes sociales y los materiales educativos, donde la veracidad de las imágenes es crucial. Personalmente, creo que herramientas como esta son esenciales para restablecer un mínimo de confianza en el contenido que se comparte masivamente.

Responsabilidad del creador y del ecosistema

El desarrollo de SynthID y su integración en Gemini demuestran un compromiso de Google con la IA responsable. Al crear una forma de rastrear las imágenes generadas por sus propios modelos, Google está asumiendo una parte de la responsabilidad por el impacto de su tecnología. Esto establece un estándar para otros desarrolladores de IA generativa. Si todos los grandes jugadores en el campo de la IA adoptaran sistemas similares de "procedencia" o "firma" para el contenido generado por sus modelos, el ecosistema digital podría convertirse en un lugar mucho más transparente. La idea de que el contenido generado por IA lleve una etiqueta inherente sobre su origen podría convertirse en una norma, lo que permitiría a los usuarios y a las plataformas diferenciar claramente entre lo que es humano y lo que es artificial. Es un paso hacia un futuro donde la transparencia en la creación de contenido no sea una opción, sino un requisito.

Limitaciones actuales y futuros desarrollos

Como se ha mencionado, la principal limitación de esta funcionalidad es que solo detecta imágenes generadas por la IA de Google. Esto significa que la gran mayoría de imágenes generadas por IA de terceros, que son muy abundantes en internet, seguirán sin ser identificables por Gemini a través de este método. Esta situación subraya la necesidad de una colaboración más amplia en la industria. Iniciativas como la Coalition for Content Provenance and Authenticity (C2PA) buscan establecer estándares abiertos para la procedencia del contenido, permitiendo que las marcas de agua digitales o los metadatos de autenticación sean compatibles entre diferentes plataformas y creadores. Si estas iniciativas ganan tracción, podríamos ver un futuro donde la detección de contenido generado por IA sea universal, independientemente del modelo o la compañía que lo creó.

La "carrera armamentista" entre la generación de IA y la detección de IA es un ciclo continuo. A medida que los modelos generativos se vuelven más sofisticados y difíciles de distinguir de la realidad, las herramientas de detección también deben evolucionar. La capacidad de Gemini es un gran primer paso, pero el camino hacia un ecosistema digital completamente transparente y verificable es largo y requerirá esfuerzos continuos de investigación, desarrollo y colaboración de la industria. Estaremos atentos a cómo estas tecnologías evolucionan y si se logra una interoperabilidad que beneficie a todos los usuarios. Para entender mejor estas iniciativas, puedes visitar el sitio web de la C2PA: Coalition for Content Provenance and Authenticity.

En resumen, la capacidad de Gemini para identificar imágenes generadas por la IA de Google es una adición poderosa y oportuna. Aunque limitada en su alcance actual, representa un compromiso significativo de Google con la responsabilidad en la era de la IA generativa. Al equipar a Gemini con SynthID, Google no solo mejora la utilidad de su asistente de IA, sino que también contribuye activamente a la alfabetización digital y a la lucha contra la desinformación. Este es un paso fundamental hacia un futuro donde la autenticidad digital pueda ser verificada con mayor facilidad, ayudándonos a todos a navegar con más confianza por el cada vez más complejo panorama de la información visual. La evolución de esta tecnología y la adopción de estándares similares por parte de otros actores de la industria serán cruciales para determinar el éxito a largo plazo en la preservación de la verdad en nuestro mundo digital.

Inteligencia artificial Gemini Detección de IA Desinformación SynthID