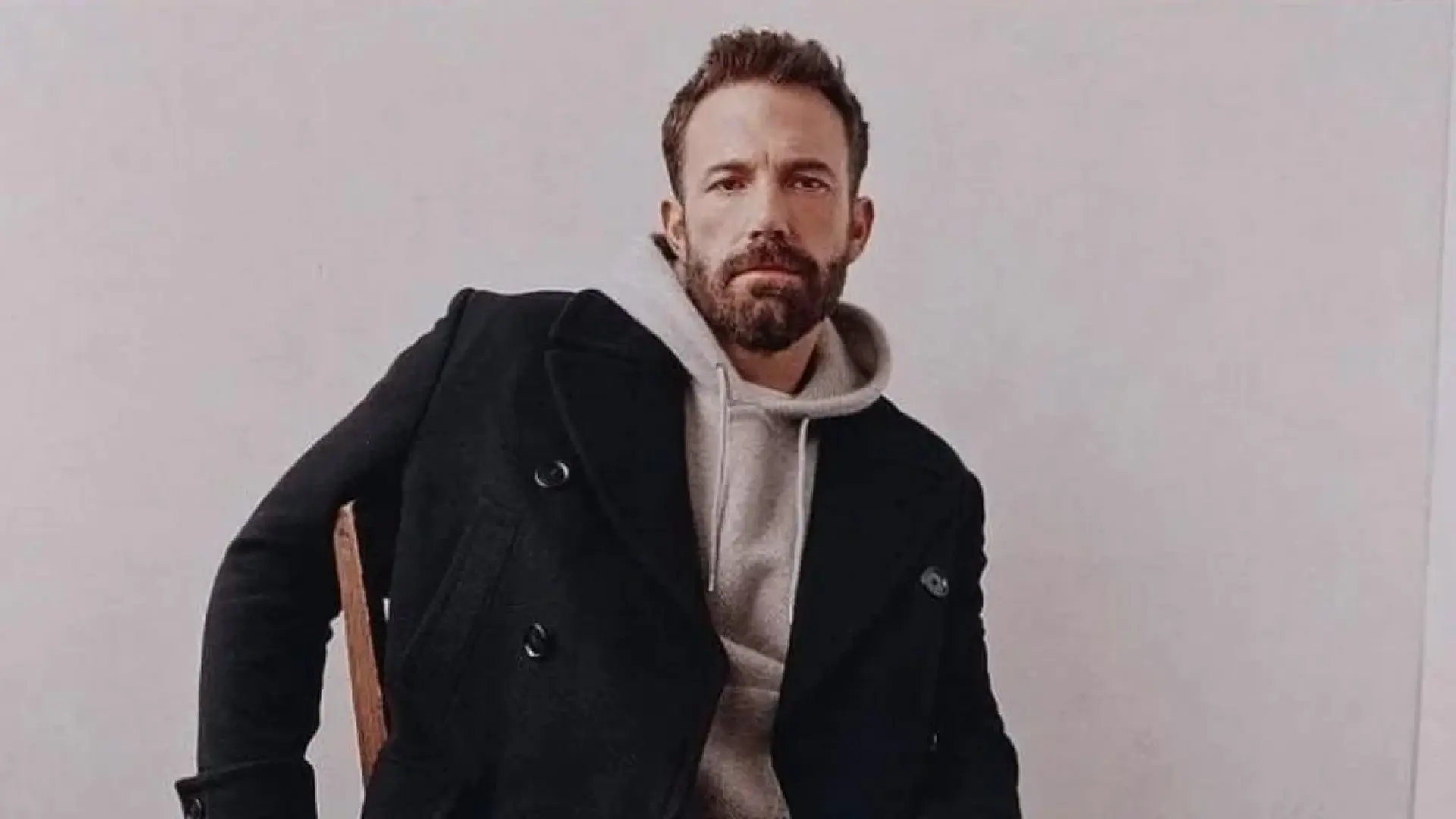

En un mundo cada vez más interconectado y tecnológicamente avanzado, la inteligencia artificial (IA) se ha consolidado como uno de los pilares de la innovación moderna. Desde la automatización de procesos hasta la creación de modelos de lenguaje capaces de dialogar con una fluidez asombrosa, sus avances han redefinido industrias enteras y modificado nuestra vida cotidiana. Sin embargo, en medio de esta euforia, surge de vez en cuando una voz que, desde una perspectiva diferente, plantea una pregunta incómoda: ¿estamos realmente progresando a la velocidad que se nos promete, o hay una meseta en el horizonte? Recientemente, el reconocido actor y director Ben Affleck, conocido por su agudeza y a veces por sus comentarios directos, ha compartido una reflexión que ha resonado en algunos círculos: "Los avances en inteligencia artificial se están estancando". Esta afirmación, proveniente de una figura pública fuera del epicentro de la investigación en IA, no solo capta la atención, sino que también nos invita a una introspección profunda sobre la naturaleza del progreso tecnológico. ¿Es la percepción de Affleck un reflejo de una realidad subyacente que los expertos podrían estar pasando por alto, o se trata de una visión simplificada de un campo intrínsecamente complejo y en constante evolución? Este post busca desglosar la validez de tal aseveración, explorando las múltiples facetas de la IA, sus logros innegables, sus desafíos persistentes y la divergencia entre la percepción pública y la realidad científica. La conversación no es menor, pues toca el nervio de nuestras expectativas sobre el futuro digital y la dirección que estamos imprimiendo a una de las tecnologías más transformadoras de nuestra era.

El origen y la resonancia de la declaración de Ben Affleck

Cuando una figura del calibre de Ben Affleck emite una opinión sobre un tema tan técnico como la inteligencia artificial, es natural que genere debate. Affleck no es un ingeniero informático ni un investigador en el campo de la IA, lo cual, para algunos, podría desestimar la relevancia de su comentario. Sin embargo, su posición como observador externo y figura pública le otorga una plataforma única para reflejar el sentir de una parte de la población que, sin ser experta, interactúa con la tecnología a diario y forma sus propias percepciones. La declaración de Affleck, cuya procedencia exacta podría variar (quizás una entrevista, un comentario informal o una reflexión más elaborada), encapsula una preocupación que subyace en ciertos debates públicos: la brecha entre la promesa exuberante de la IA y la experiencia práctica que muchos usuarios tienen con ella.

Es fundamental entender que la percepción de "estancamiento" puede ser muy subjetiva. Para el público general, que quizás asocia la IA con robots humanoides de ciencia ficción o asistentes virtuales que todavía luchan con la complejidad del lenguaje natural, el ritmo de cambio podría parecer lento. Han pasado décadas desde que se empezó a hablar de IA en la cultura popular, y aún no hemos alcanzado la inteligencia artificial general (AGI) que muchos imaginaron. Affleck, al articular esta sensación, se convierte en un eco de esa frustración latente, una voz que cuestiona si el progreso es tan lineal o explosivo como los titulares a menudo sugieren. Su comentario, en este sentido, es menos una crítica técnica y más una observación sobre la percepción del ritmo de la innovación.

Además, el entorno mediático actual, saturado de noticias sobre "revoluciones" tecnológicas, puede generar una fatiga que distorsiona la apreciación del verdadero progreso. Cada año se anuncia "el fin de la inteligencia artificial tal como la conocemos", seguido por un nuevo lanzamiento que, si bien es impresionante, quizás no cumple con las expectativas de un salto cuántico que la narrativa mediática a menudo construye. En este contexto, la declaración de Affleck no debería ser ignorada; más bien, debe ser vista como una oportunidad para examinar cómo se comunica el progreso de la IA y cómo se alinea con las expectativas del público. A menudo, lo que para los investigadores son avances incrementales significativos, para el ojo inexperto puede parecer una repetición de lo ya visto o un simple perfeccionamiento.

¿Qué significa realmente "estancamiento" en el contexto de la inteligencia artificial?

Para analizar la declaración de Affleck, es crucial definir qué se entiende por "estancamiento" en un campo tan dinámico como la IA. El término puede interpretarse de diversas maneras, cada una con implicaciones distintas para el futuro de la tecnología.

La brecha entre la expectativa y la realidad

Una de las interpretaciones más comunes, y quizás la que resuena con la opinión de Affleck, es la discrepancia entre las promesas a largo plazo de la IA (como la inteligencia artificial general, o AGI) y las capacidades actuales de los sistemas. Desde los albores de la IA, ha existido la visión de máquinas que no solo imitan la inteligencia humana, sino que la superan en todos los aspectos cognitivos. Sin embargo, a pesar de los avances monumentales en áreas específicas, la AGI sigue siendo un objetivo lejano, un horizonte que parece retroceder a medida que nos acercamos. Esta "promesa incumplida" a largo plazo podría generar una sensación de estancamiento para quienes esperan una revolución total y no una evolución gradual.

Los límites del paradigma actual: el aprendizaje profundo

Otra interpretación del estancamiento podría apuntar a los límites inherentes del paradigma dominante actual en IA: el aprendizaje profundo (deep learning). Si bien el aprendizaje profundo ha sido responsable de la mayor parte de los éxitos recientes de la IA –desde el reconocimiento de imágenes y voz hasta los modelos de lenguaje grandes (LLMs)–, también presenta desafíos significativos. Estos sistemas son increíblemente "hambrientos" de datos, requieren vastas cantidades de energía computacional y a menudo actúan como "cajas negras", lo que dificulta comprender por qué toman ciertas decisiones. Además, son susceptibles a sesgos presentes en los datos de entrenamiento y carecen de una verdadera comprensión del mundo o de la capacidad de razonamiento de sentido común.

Algunos expertos argumentan que, aunque estamos obteniendo resultados cada vez más impresionantes a través de la escalada de estos modelos (más datos, más parámetros, más computación), no estamos viendo avances fundamentales en la arquitectura o en los principios subyacentes. Es decir, estamos mejorando una tecnología existente en lugar de inventar una completamente nueva. Esto podría interpretarse como un estancamiento en la investigación teórica o en la búsqueda de paradigmas alternativos que superen las limitaciones actuales del aprendizaje profundo. Personalmente, encuentro que esta distinción entre "avances de ingeniería" y "avances conceptuales" es clave para entender la crítica; si bien lo primero es innegable, lo segundo podría ser motivo de debate.

Avances innegables y su impacto en la sociedad

A pesar de la perspectiva de Affleck, es imperativo reconocer que el campo de la IA ha experimentado una explosión de innovación y aplicación en la última década, desmintiendo la idea de un estancamiento generalizado en muchas áreas.

Modelos de lenguaje grandes (LLMs) y la IA generativa

Quizás el avance más visible y disruptivo de los últimos años haya sido el surgimiento y la maduración de los modelos de lenguaje grandes (LLMs) como GPT-3, GPT-4 y otros. Estas herramientas han transformado la forma en que interactuamos con la información, permitiendo la creación de contenido textual de alta calidad, la traducción automática con una fluidez asombrosa, la asistencia en la programación y una miríada de aplicaciones en atención al cliente, marketing y educación. La capacidad de la IA generativa para crear no solo texto, sino también imágenes, música y video a partir de simples instrucciones, representa un salto cualitativo en la creatividad asistida por máquinas. ¿Cómo se puede hablar de estancamiento cuando herramientas como ChatGPT o Stable Diffusion están redefiniendo industrias enteras?

IA en ciencia, medicina e investigación

Más allá de las aplicaciones de consumo, la IA está impulsando revoluciones silenciosas en laboratorios y centros de investigación. En la medicina, la IA ayuda al diagnóstico temprano de enfermedades, al descubrimiento de nuevos fármacos y a la personalización de tratamientos. Algoritmos de aprendizaje automático analizan vastos conjuntos de datos genómicos y proteómicos, identificando patrones que serían imposibles de discernir para el ojo humano. En la ciencia de materiales, la IA acelera la creación de nuevos compuestos con propiedades específicas. En la astronomía, procesa montañas de datos de telescopios para descubrir exoplanetas y fenómenos cósmicos. La aceleración del descubrimiento científico es un testimonio elocuente de que la IA está lejos de estancarse en estos dominios críticos. Un ejemplo claro es el trabajo de AlphaFold en la predicción de estructuras de proteínas, que ha sido un cambio de juego para la biología.

Robótica y automatización inteligente

La fusión de la IA con la robótica está dando lugar a una nueva generación de sistemas autónomos capaces de operar en entornos complejos. Desde robots industriales que realizan tareas de fabricación con precisión milimétrica hasta vehículos autónomos que prometen transformar el transporte, la IA es el cerebro detrás de estas máquinas. Los avances en visión por computadora, planificación de movimiento y aprendizaje por refuerzo permiten a los robots adaptarse a situaciones imprevistas y aprender de la experiencia. Aunque la robótica humanoide avanzada aún enfrenta desafíos, la proliferación de robots colaborativos y de servicio en diversos sectores es una prueba irrefutable de un progreso continuo y acelerado.

Desafíos y posibles frenos al progreso

Si bien los avances son innegables, es cierto que existen desafíos significativos que podrían dar una impresión de estancamiento, especialmente si se mira la IA desde ciertas perspectivas o con ciertas expectativas.

El problema de la inteligencia artificial general (AGI)

Como mencionamos, la AGI sigue siendo el "santo grial" de la IA. La capacidad de una máquina para entender, aprender y aplicar su inteligencia a cualquier tarea intelectual que un ser humano pueda realizar, sigue siendo un objetivo extraordinariamente complejo. A pesar de los impresionantes logros en IA estrecha (sistemas diseñados para tareas específicas), estamos lejos de crear una inteligencia verdaderamente generalista. Los métodos actuales, aunque potentes, no parecen conducir directamente a la AGI, lo que genera frustración en quienes esperan un salto más holístico en la capacidad de las máquinas. Esta brecha entre la IA actual y la AGI es quizás la fuente principal de la percepción de estancamiento en la visión de largo plazo.

Dependencia de grandes volúmenes de datos y poder computacional

Los modelos de aprendizaje profundo requieren cantidades masivas de datos para entrenarse y un poder computacional exorbitante, lo que los hace costosos y energéticamente ineficientes. Esta dependencia crea barreras de entrada significativas para investigadores y empresas más pequeñas, concentrando el desarrollo de IA avanzada en manos de unas pocas corporaciones gigantes con recursos casi ilimitados. Si bien la escalada ha funcionado hasta ahora, hay indicios de rendimientos decrecientes. ¿Podemos seguir aumentando el tamaño de los modelos indefinidamente, o llegaremos a un punto en el que el costo-beneficio no sea sostenible? Esta es una preocupación válida y un posible "cuello de botella" para el progreso futuro. Puede encontrar más información sobre el impacto del poder computacional en la IA en MIT Technology Review.

Sesgos, equidad y consideraciones éticas

A medida que la IA se integra más profundamente en la sociedad, los problemas de sesgo en los datos de entrenamiento y las decisiones algorítmicas injustas se han vuelto alarmantemente evidentes. Los sistemas de reconocimiento facial que funcionan peor en ciertas etnias, algoritmos de contratación que discriminan por género, o sistemas de justicia predictiva que perpetúan desigualdades sociales, son ejemplos claros. Abordar estos problemas requiere no solo mejoras técnicas, sino también un enfoque multidisciplinar que incluya ética, sociología y políticas públicas. La falta de un progreso sustancial en hacer la IA verdaderamente justa y equitativa podría interpretarse como un estancamiento en la aplicación responsable y ética de la tecnología, un área donde, francamente, creo que estamos avanzando demasiado lento. La Unión Europea, por ejemplo, está intentando abordar estos temas con su Ley de Inteligencia Artificial.

La "fatiga" de la innovación incremental

Para el observador externo, la constante corriente de noticias sobre mejoras incrementales en los modelos existentes puede, irónicamente, generar una sensación de monotonía. Si bien los expertos aprecian el refinamiento de arquitecturas y la mejora de métricas, el público general puede no percibir estos avances como "nuevos" o "revolucionarios" de la misma manera que lo fue la aparición inicial de los modelos generativos. Esta "fatiga de la innovación" puede contribuir a la impresión de que el campo se está "estancando", aunque en realidad esté experimentando un crecimiento continuo, aunque menos espectacular en sus titulares.

La visión de la comunidad experta

La declaración de Ben Affleck, aunque provocadora, contrasta con la visión generalizada de la mayoría de los investigadores y desarrolladores en el campo de la IA. Si bien pocos negarían los desafíos inherentes, la perspectiva predominante es de un optimismo cauteloso y una búsqueda incansable de nuevas fronteras.

Los expertos suelen distinguir entre "estancamiento fundamental" y "estancamiento aplicado". En el plano fundamental, se reconoce que ha habido un predominio del aprendizaje profundo en los últimos años, y que la búsqueda de paradigmas totalmente nuevos (como la IA simbólica renovada o la IA basada en la neurociencia computacional) es un área activa pero aún sin un nuevo "paradigma disruptivo" a gran escala. Sin embargo, en el plano aplicado y en el perfeccionamiento de las técnicas existentes, el progreso es innegable. La eficiencia de los algoritmos mejora, la capacidad de los modelos crece y las aplicaciones se diversifican a un ritmo vertiginoso.

La comunidad investigadora está activamente explorando alternativas y soluciones a los límites del aprendizaje profundo. Se investiga la IA explicable (XAI) para abrir las "cajas negras", la IA federada para proteger la privacidad de los datos, la IA neuromórfica inspirada en el cerebro biológico, y el aprendizaje por refuerzo en entornos más complejos. Hay un reconocimiento creciente de que la siguiente gran ola de IA podría no ser solo escalar lo que ya tenemos, sino integrar diferentes enfoques, quizás fusionando el aprendizaje profundo con el razonamiento simbólico o modelos causales. Este dinamismo, la constante búsqueda de "lo siguiente", difícilmente encaja con la idea de un estancamiento.

Mi opinión personal es que la declaración de Affleck es una simplificación de una realidad compleja. Es cierto que la AGI no está a la vuelta de la esquina y que la IA se enfrenta a desafíos éticos y computacionales significativos. Sin embargo, equiparar esto con "estancamiento" es ignorar el torbellino de innovación que sigue transformando innumerables sectores. Quizás la IA está evolucionando de una manera más sutil y menos espectacular que la que el público espera de la ciencia ficción, pero no por ello menos profunda o impactante. El progreso a menudo se percibe de forma no lineal; hay periodos de euforia, mesetas de consolidación y luego nuevos saltos. Estamos posiblemente en una fase de consolidación y perfeccionamiento intensivo antes de la próxima gran disrupción.

El futuro de la inteligencia artificial: ¿Más allá del estancamiento?

Mirando hacia el futuro, la trayectoria de la inteligencia artificial parece estar más allá de cualquier percepción de estancamiento. En lugar de una desaceleración, lo que se vislumbra es una maduración del campo y una diversificación de las líneas de investigación.

Nuevas fronteras de investigación y paradigmas emergentes

La investigación no se detiene en los límites del aprendizaje profundo. Las nuevas fronteras incluyen:

- IA explicable (XAI): Desarrollar sistemas que no solo tomen decisiones, sino que también puedan explicar el porqué, aumentando la confianza y la auditabilidad.

- IA de pocos disparos (Few-shot learning) y sin disparos (Zero-shot learning): Crear modelos que puedan aprender de muy pocos ejemplos o incluso sin ejemplos directos, emulando más de cerca la eficiencia del aprendizaje humano.

- IA federada y aprendizaje de la privacidad: Permitir que los modelos aprendan de datos descentralizados sin que estos datos abandonen sus fuentes originales, abordando preocupaciones de privacidad y seguridad.

- Inteligencia artificial aumentada (Augmented AI): Centrarse en la colaboración entre humanos y máquinas, donde la IA potencia las capacidades humanas en lugar de reemplazarlas.

- Modelos causales: Superar la correlación para entender la causa y efecto, lo que es fundamental para una inteligencia más profunda y robusta.

Estos y muchos otros campos de investigación sugieren un ecosistema vibrante donde la creatividad y la innovación están lejos de estancarse, buscando activamente superar las limitaciones actuales y explorar nuevos horizontes. La clave reside en la capacidad de la comunidad científica para pivotar y explorar paradigmas que no dependen exclusivamente de la escala computacional o la cantidad masiva de datos. La interdisciplinariedad será vital, integrando conocimientos de neurociencia, psicología cognitiva y otras ciencias humanas para inspirar la próxima generación de algoritmos.

La importancia de la colaboración interdisciplinar y la regulación

El futuro de la IA no es puramente tecnológico. Para que los avances sean sostenibles y beneficien a la sociedad en su conjunto, es crucial la colaboración interdisciplinar. Esto implica no solo ingenieros y científicos de datos, sino también filósofos, sociólogos, juristas y éticos. La formulación de marcos r