Publicado el 14/05/2024 por Diario Tecnología

Artículo original

El papel de las autocaravanas en Canarias resulta, cuanto menos, peculiar. La escasez y el elevado coste de la vivienda en el archipiélago, sometido a una intensa presión turística, las convirtió en su día en la alternativa asequible para quienes no podían pagar un alquiler convencional. A falta de casa o piso al uso, buena era una caravana o furgoneta camperizada. Ahora estos vehículos han pasado a destinarse a otros uso bastante distinto: el alquiler vacacional para turistas. En Arona, una localidad del sur de Tenerife, ya han identificado algunos casos. E incluso hay quien asegura que se están empleando también para ejercer la prostitución.

Lo más curioso es que las autocaravanas no solo han llamado la atención de las autoridades canarias. Algo similar ha ocurrido también en las Baleares.

Caravana no, piso de vacaciones.

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

Estamos en pleno Google I/O y, como parte de la batería de novedades presentadas por la compañía, llegan mejoras en Gemini 1.5. Gemini una familia de modelos de inteligencia artificial que potencia tecnologías como el nuevo asistente de voz que vendrá para remplazar a Google Assistant, por lo que las mejoras en los tiempos de ejecución del modelo resultan cruciales para sus diversas implementaciones (ya sea en web, apps o asistentes).

Actualmente, Gemini tiene tres versiones: Ultra, Pro y Nano. Ultra es el principal rival de GPT4, Pro compite con soluciones gratuitas como GPT 3.5, y Nano es la integración que vemos en dispositivos con IA de Google integrada como los Google Pixel 8 o los Samsung Galaxy S24. Las novedades de este IO se centran en Gemini 1.5 , disponible a través de la suscripción Gemini Advanced.

Un modelo más ligero y rápido. Gemini Flash es el nombre que ha dado Google a su propuesta más ligera, con menor latencia y, sobre todo, veloz. Es una apuesta con una capacidad de respuesta más rápida que 1.5 Pro, diseñado para aquellas aplicaciones en las que lo que prima es la celeridad.

Supone la última incorporación a la familia de modelos Gemini, y está optimizado para tareas de gran volumen. Pese a ser más ligero que Pro, Google promete una gran capacidad de razonamiento multimodal, siendo especialmente bueno en resúmenes, aplicaciones de chat, subtitulación de imágenes o extracción de datos en documentos.

Mejoras en la capacidad de cálculo. Gemini 1.5 Pro es un modelo que aumenta la capacidad de cálculo respecto a versiones anteriores. Ahora es capaz de de analizar documentos de gran tamaño: archivos de hasta 1.500 páginas en total, resumen de hasta 100 correos electrónicos de forma simultánea, una hora de vídeo o bases de código de más de 30.000 líneas.

Dado que la principal bondad de Gemini 1.5 Pro es esta capacidad de cálculo, Google quiere una mayor integración de Drive con Gemini, permitiendo subir archivos de este último servicio a Gemini. En otras palabras, podremos acceder al poder de cálculo de Gemini 1.5 Pro en los documentos.

Mejoras en la comprensión de imágenes. Gemini 1.5 Pro promete importantes mejoras a la hora de entender las imágenes que le estamos mostrando. Como ejemplo, Google presume de que su modelo puede resolver problemas matemáticos paso a paso con tan solo analizar una foto, o darte recetas de un plato con tan solo ver su composición y aspecto.

No solo aplica a multimedia: también a apps. Gemini será capaz de analizar el contenido de aplicaciones como Google Meet o Gmail para hacer resúmenes, descripciones de lo que ve transcritas a texto y más funciones.

Gemini 1.5 Pro estará disponible para los suscriptores de Gemini Advanced en algo más de 150 países y en más de 35 idiomas. Desde Google nos han confirmado que la suscripción llegará a España.

Gemini será más compatible con móviles. Con el fin de mejorar las capacidades conversacionales de Gemini, Google anuncia el lanzamiento de Gemini Live para los suscriptores de Gemini Advanced, así como nuevas funciones que integrarán Gemini en Android.

Entre ellas, llegará la búsqueda mediante IA a Google Fotos, pudiendo analizar el contexto de las mismas, hablarnos sobre lo que ve, e ir mucho más allá de la actual búsqueda. También habrá integración de Gemini en apps como Mensajes, donde servirá de apoyo para las conversaciones.

Respecto a Gemini Live, es una nueva interfaz de conversación con Gemini exclusiva para teléfonos móviles. Al igual que mostró hace unas horas OpenAI con GPT-4o, podremos interrumpir al bot, como en una conversación habitual.

Del mismo modo, Gemini Live puede ver a través de nuestra cámara, describiendo con precisión el entorno en el que estamos. Estas novedades por el momento, se están probando en inglés, por lo que no llegarán en primera instancia a España.

Mejoras en la planificación. Además de las mejoras que llegan de la mano de Gemini Flash, Gemini Live, y las capacidades de Gemini Pro, Google quiere dotar a Gemini Advanced de mejoras en planificaciones complejas. Itinerarios de viaje, planes, actividades en las que tenemos que escoger entre diversas opciones, etc.

Una de las funciones que llegará al plan Advanced dentro de "los próximos meses" tendrá que ver con las planificaciones. Si, por ejemplo, le pedimos que nos planifique un viaje, será capaz de tener en cuenta los horarios de vuelo, llegada a hotel, preferencias de comida que le indiquemos e demás para ofrecernos una planificación personalizada.

Lo hará obteniendo datos de apps como Gmail, Google Maps y la búsqueda de Google, y modificará la planificación completa si hacemos algún cambio en el itinerario.

Imagen | Google

En Xataka | 36 funciones y cosas que puedes hacer con Google Gemini

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

La avalancha de novedades en los modelos de IA generativa de Google se ha completado con un anuncio muy especial. Project Astra es la ambiciosa iniciativa de Google para plantear el asistente de voz del futuro. Uno potenciado por la IA y por la visión que proporcionan las cámaras de nuestros smartphones (o, como veremos, de otros dispositivos).

Project Astra. Así se llama este ambicioso proyecto de Google con el que quieren "desarrollar agentes de IA universales que puedan ser útiles en nuestra vida cotidiana". En Google destacaban como un asistente de estas características debe ser capaz de entender y responder de la misma forma que lo hacen los humanos. También "recordar lo que ve y oye para entender el contexto y actuar".

La latencia es el reto. Los responsables de la empresa reconocen que han avanzado mucho en la comprensión de información multimodal (esto es, que le llegan datos de texto, de voz, de audio, de vídeo). Sin embargo, "reducir el tiempo de respuesta a algo orientado a la conversación es un reto ingenieril difícil".

Tonos de voz. En Project Astra están trabajando en ofrecer modelos de síntesis de voz que tengan mayor calidad y que permitan que los distintos agentes tengan una amplia variedad de entonaciones. Según Google, los agentes serán capaces de entender el contexto en el que se están usando mejor que nunca, y además responderán rápido.

La app de Gemini en el horizonte. Todo ese aprendizaje acabará integrado en soluciones como la aplicación móvil de Gemini, que será equivalente a la que OpenAI ha presentado con ese ChatGPT basado en GPT-4o que vimos ayer. La aplicación, indican en Google, estará disponible antes de que acabe el año.

Esas gafas que lleva esta ingeniera de Google tienen integrada la tecnología de Project Astra. Esto promete.

Esas gafas que lleva esta ingeniera de Google tienen integrada la tecnología de Project Astra. Esto promete.

Dime lo que ves. En el vídeo de demostración publicado por Google se veía en funcionamiento una versión preliminar de Project Astra que hacía uso de las cámaras del móvil para reconocer objetos de forma sorprendente. De hecho en Google planteaban opciones curiosas, como las de dibujar una flecha en la pantalla para luego pedirle al modelo que describiera qué era ese objeto en pantalla. Nos recuerda a esa nueva característica de "Rodear para buscar", pero en este caso aplicada a esas consultas en directo sobre cosas que el modelo de IA reconoce.

¡Gafas! Lo más llamativo del vídeo llegó en la parte final, cuando la persona que está realizando la demostración pregunta "¿Dónde he dejado mis gafas". El asistente se lo indica, y cuando se las pone resulta que no son unas gafas de ver normales: ¡son unas gafas con cámara y la integración de Project Astra! (Unas que nos recuerdan a algo, por cierto). A partir de ahí la usuaria hace unas breves demostraciones de cómo gracias a esa integración el modelo va ayudando y respondiendo a las preguntas de la usuaria de forma notable e ingeniosa.

OpenAI va por delante, pero Google acecha. Project Astra parece por tanto ser un competidor directo de las funciones que ayer se presentaron con GPT-4o por parte de OpenAI. La firma liderada por Sam Altman parece haberse adelantado ligeramente porque esas opciones de interacción por voz ya están llegando poco a poco a algunos usuarios, pero su disponibilidad masiva probablemente tarde varias semanas... o meses. Google va ligeramente retrasada, pero esta alternativa parece igual de prometedora y será una interesante forma de animar esta particular competencia. Los ususarios saldremos ganando, eso seguro.

En Xataka | OpenAI acaba de acercarnos más que nunca a 'Her': su nuevo modelo de voz nos acompañará (y quizás enamorará)

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

Google ha aprovechado su evento para desarrolladores, el I/O 2024, para hacer varios anuncios sobre novedades en sus servicios, incluido su buscador. En este caso, ha comunicado cómo van a ser las búsquedas a partir de ahora en su producto rey.

Por supuesto, la IA generativa es la piedra angular de este cambio. Y con él nos despedimos de los resultados tradicionales, con los diez enlaces en color azul rodeados de snippets en los últimos años.

Por qué importa. Google es el rey absoluto de las búsquedas y la principal vía de negocio de Alphabet. Es la forma esencial de acceder a Internet y de descubrir contenido para miles de millones de personas. Pocos cambios en el mundo online tienen tanto impacto como los que haga Google.

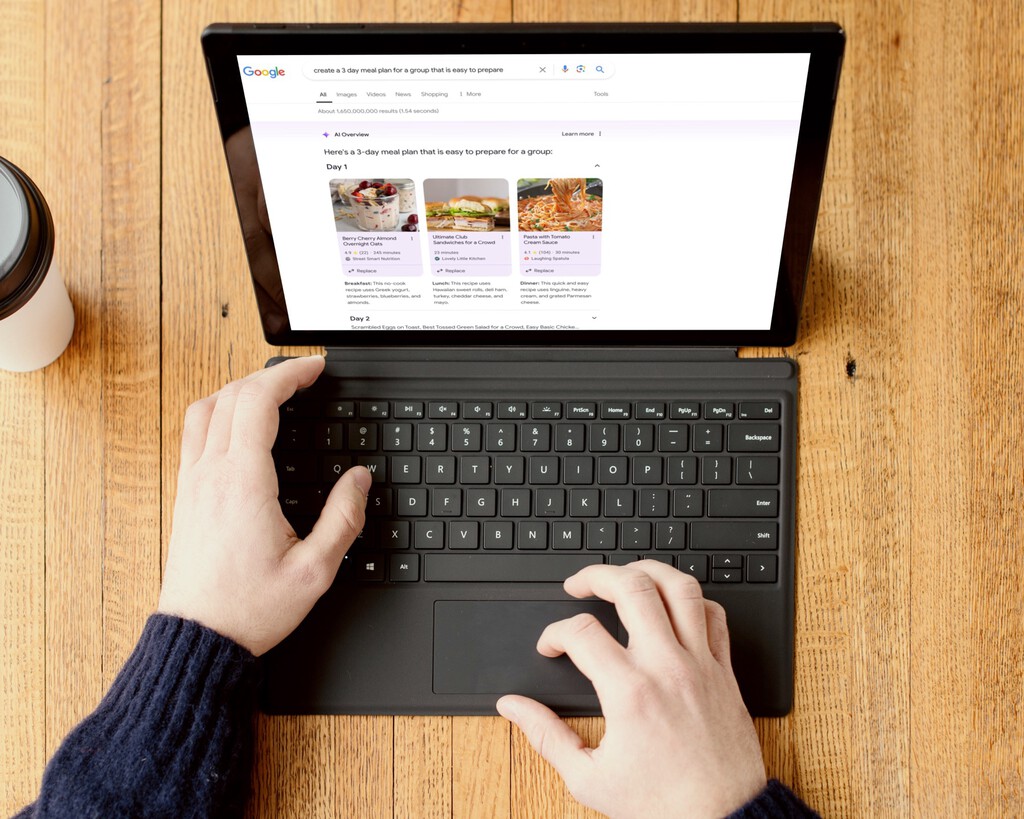

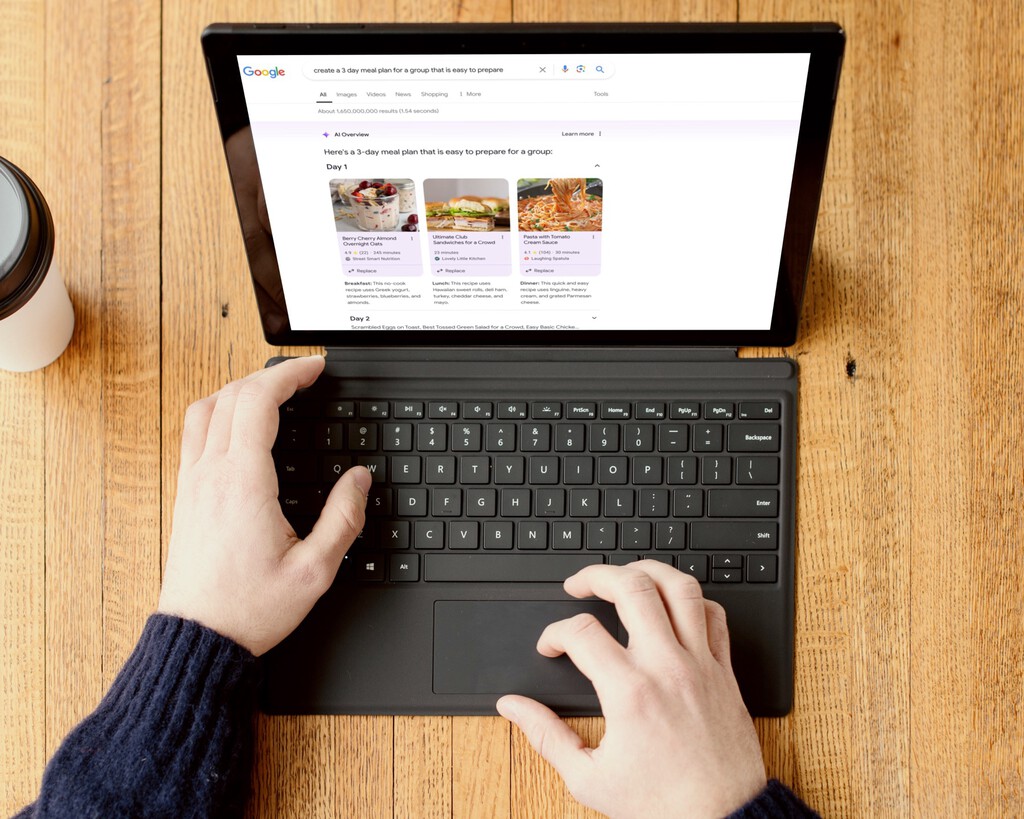

Visión general. Google está integrando Gemini en sus resultados de búsqueda. Ya no solo devolverá enlaces y snippets a nuestras palabras clave, también dará respuestas elaboradas a consultas realizadas en lenguaje natural.

Con una interfaz similar a la de los snippets, pero con su propia entidad, estos resultados sintéticos se ajustarán a lo que el usuario pide. Algunos ejemplos:

- "Explica la conexión entre los rayos y los truenos" → El primer resultado será una caja de texto que lo explique brevemente.

- "Crea un plan de tres comidas fáciles de hacer para un grupo" → Veremos tres propuestas con la imagen de cada receta, podremos reemplazar cada una si queremos otra, y veremos las instrucciones para preparar cada una.

- "Encuentra las mejores escuelas de yoga en Boston, con al menos un promedio de 4.1 en sus valoraciones, a menos de media hora a pie de mi trabajo" → La búsqueda se centra en mostrar escuelas de yoga que se ajusten a esa descripción.

Imagen: Google.

Imagen: Google.

Imagen: Google.

Imagen: Google.

Imagen: Google.

Imagen: Google.

Es decir: combina imágenes, mapas, enlaces y cualquier tipo de información para hacer una planificación. Los ejemplos son muy concretos, son funciones específicas desarrolladas por Google para estos resultados.

También en vídeo. Gemini en Google permitirá a los usuarios adjuntar vídeos para las búsquedas que sean complicadas de describir con palabras. Por ejemplo, añadiendo el vídeo de un dispositivo electrónico averiado para que el buscador intente detectar el fallo y le indique la forma de repararlo.

Lanzamiento escalonado. Estas nuevas funciones están disponibles inicialmente en inglés y en Estados Unidos, pero hay planes de expansión a otras regiones e idiomas. Google permite inscribirse en sus Search Labs para el acceso anticipado a estas funciones.

En Xataka | 36 funciones y cosas que puedes hacer con Google Gemini

Imagen destacada | Google, Mockuuups Studio, Xataka

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

En el mundo postapocalíptico de Fallout hay que reconocer que escasean todos los tipos de recursos, de ahí que cualquier artículo o material sea tan importante. Pero si hay uno que sobresale por encima de todos son las chapas de las botellas, ya que están consideradas como la moneda de cambio que se utiliza en este universo.

El hecho de que sean tan demandadas implica que no abunden considerablemente, de ahí su rareza y que sean tan codiciadas. No obstante, hay un jugador que ahora puede presumir de haberse encontrado con el mayor premio de toda su vida, porque mientras estaba jugando a Fallout 4 ha conseguido de golpe nada más y nada menos que 99 millones de chapas.

Desde luego, su cara de sorpresa ante este hecho tuvo que ser digna de enmarcar. Además, no hizo nada en especial, ya que simplemente estaba combatiendo contra un enemigo. Una vez derrotado se puso a examinar sus bolsillos para extraer sus pertenencias, momento en el que se encontró con unos cuantos artículos y con semejante cantidad de dinero que llevaba encima.

Resulta curioso que alguien estuviese viajando por el Yermo con tantísimos millones de chapas. Aun así, Arkayne97, el usuario que ahora puede presumir de ser el hombre más rico de todos, no dudo en sacar una foto a la pantalla para mostrar el premio gordo que le ha tocado, ya que queda claro que el dinero no volverá a ser un problema para él nunca más.

No son pocos los usuarios que han comentado a la publicación quedándose a cuadros, entre los que no han faltado algunos acusándole de haber hecho trampas o de haber realizado alguna modificación en el juego. No obstante, él mismo ha garantizado que en ningún momento ha llevado a cabo algún truco y tampoco ha empleado ningún tipo de mod, prometiendo que todo es legítimo. Eso sí, no descarta que se haya podido deber a un error, aunque de ser así, bendito fallo.

En VidaExtra | He encontrado el lugar perfecto de Fallout 76 para establecer mi campamento: apartado, seguro y con vistas a los petardazos nucleares

En VidaExtra | He flipado mientras exploraba Skyline Valley, la nueva zona de Fallout 76, y ahora solo quiero que se lance para desvelar sus misterios

En VidaExtra | Fui a comprar algunos planos de Fallout 76 y acabé perdido en un búnker enorme digno de una película de Hollywood

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

Entre todas las novedades anunciadas en su evento Google I/O, la compañía ha anunciado el lanzamiento de dos nuevos modelos de inteligencia artificial generativa: Veo, su modelo más avanzado para la generación de videos en alta definición, e Imagen 3, su modelo de texto a imagen de mayor calidad hasta la fecha.

Veo: una alternativa a Sora

Veo es el modelo de generación de video más avanzado de Google hasta la fecha. Este modelo es capaz de crear vídeos en alta definición (1080p) que pueden durar más de un minuto, cubriendo una amplia gama de estilos visuales y cinematográficos.

Pero lo más relevante es la consistencia y coherencia del metraje generado por Veo, con personas, animales y objetos que se mueven de manera realista a lo largo de las tomas.

Además, gracias a su comprensión avanzada del lenguaje natural y la semántica visual, Veo puede generar videos que reflejan fielmente la visión creativa del usuario, siendo capaz de entender términos cinematográficos como "timelapse" o "tomas aéreas de un paisaje", y ofreciendo así un control creativo sin precedentes.

Google ha estado invitando a cineastas y creadores a experimentar con Veo, a imagen y semejanza de lo que ha estado haciendo OpenAI con Sora. Un ejemplo de esto es la colaboración con el cineasta Donald Glover y su estudio creativo Gilga, quienes ya han experimentado con Veo en un proyecto cinematográfico.

Imagen 3: Dando batalla a DALL-E 3

El modelo Imagen 3 de Google es su modelo de IA de texto-a-imagen (como MidJourney o DALL-E 3) de mayor calidad hasta la fecha: Imagen 3 genera imágenes fotorrealistas y detalladas con menos 'artefactos' (defectos) visuales que sus predecesores.

Este modelo no solo entiende mejor el lenguaje natural y la intención detrás de los prompts introducidos por los usuarios, sino que también incorpora pequeños detalles que mejoran la fidelidad de las imágenes generadas.

Imagen 3 es especialmente eficaz renderizando texto dentro de las imágenes (ver imagen anterior), una capacidad que abre nuevas posibilidades como la creación de mensajes de cumpleaños personalizados o diapositivas para presentaciones.

Al igual que Veo, Imagen 3 está disponible en vista previa privada para un grupo selecto de creadores dentro de ImageFX (con la posibilidad de unirse a la lista de espera) y próximamente estará disponible en Vertex AI.

En Genbeta | Esta inteligencia artificial te permite crear todo tipo de imágenes 3D con tu nombre gratis y con intentos ilimitados: así funciona

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

Estamos viviendo una semana que está protagonizada por la inteligencia artificial de las principales empresas tecnológicas del sector. Este lunes vimos como OpenAI lanzó su nuevo modelo GPT-4o y también una experiencia que puede llegar a sustituir a nuestros profesores, así como la nueva app para ordenador. Esto hizo que el hype por los avances en inteligencia artificial fueran realmente significativos.

Este martes se ha celebrado el Google I/O 2024 siendo uno de los eventos más importantes para la compañía con el objetivo de presentar sus novedades en Android y también en inteligencia artificial.

Una de las partes más importantes en este caso han sido los avances en Gemini 1.5, tanto en su versión Pro como la nueva versión Flash que está encaminada a aquellos textos que son mucho más extensos.

Gemini 1.5 Flash llega para poder analizar libros enteros

Una de las primeras mejoras en Gemini está en la presentación de Gemini 1.5 Flash. Por el apellido que tiene este modelo podemos llegar a pensar que está centrado sobre todo en la rapidez de los procesos, pero la realidad es que 1.5 Flash va a estar indicado para las tareas de gran volumen y alta frecuencia.

Es un modelo que es más liviano que el 1.5 Pro para poder trabajar con una gran cantidad de información. Se enfoca en realizar resúmenes, aplicaciones de chat o crear subtítulos de vídeos, además de también extraer la información de tablas o documentos extensos.

Al final hablamos de una mejora que podemos categorizar como menor, donde no vamos a poder tener a priori grandes avances, y que al final es una derivación de 1.5 Pro. Los ejemplos que presenta Google para poder comprender este nuevo modelo es el hecho de poder analizar un libro completo de ciento de páginas como "Los miserables". Este es específicamente el ejemplo que han contado en el paper de investigación.

Gemini 1.5 Pro seguirá instrucciones más complejas

La versión de Gemini 1.5 Pro ha mejorado mucho en los últimos meses, siendo presentado como el mejor modelo que podemos tener ahora en el ámbito de Gemini. Durante este evento de Google I/O han recordado como han ampliado la ventana de contexto a 2 millones de tokens, mejorado la generación de código o el razonamiento lógico.

Pero ahora Gemini 1.5 Pro va a poder seguir instrucciones más complejas y con matices como aquellas instrucciones que van a incluir el comportamiento. Además, han mejorado el control de las respuestas del modelo para poder crear personalidades concretas y el estilo de respuesta que se va a recibir por parte del chat. Esto es algo que ahora mismo se puede hacer por diferentes instrucciones específicas para personalizar la experiencia.

De manera extra, y siendo algo que hemos visto en ChatGPT, también se va a permitir la subida de archivos desde Google Drive o desde el propio dispositivo. Este es un avance importante, ya que hasta ahora para trabajar con archivos se tenía que compartir el enlace desde Drive por ejemplo. Y esto es algo que también vimos en la nueva app de ChatGPT para Mac.

En Gemini API y Google AI Studio han agregado la comprensión de audio, y de esta manera vamos a poder analizar imágenes y audio en el campo de Google AI Studio. Y esto es algo que podrá ser usado por cualquier desarrollador en todo el mundo, al abrirse desde hoy mismo.

De manera añadida Google también ha compartido actualizaciones de Gemma con Gemma 2 que es la próxima generación de modelos abiertos. Con este modelo se presenta una arquitectura que tiene el objetivo de lograr un rendimiento y una eficiencia innovadoras. Aunque no han podido ofrecer muchos detalles para ellos.

En definitiva, estamos ante nuevos avances de Gemini pero que no es una revolución como la que hemos podido ver con ChatGPT que si han conseguido llamar mucho la atención con sus nuevas inclusiones en los sistemas operativos. El verdadero cambio se espera como es lógico para Gemini 2.0, para la cual todavía vamos a tener que seguir esperando.

En Genbeta | El CEO de Google afirma que no entienden por qué su inteligencia artificial aprende cosas inesperadas. Esto son las “cajas negras”

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

OpenAI puso el listón muy alto con la llegada de ChatGPT, dando paso a una nueva era de la inteligencia artificial generativa. Al cabo de unos meses, la industria tecnológica se ha puesto patas arriba, y los máximos exponentes de una carrera por la supervivencia de las empresas en este campo incluyen a grandes compañías como Microsoft, Meta o Google, entre otras tantas.

Si bien Google despertó tarde con Bard y más adelante con Gemini, la compañía sigue su curso ofreciéndonos nuevos productos y servicios enfocados en el uso de la inteligencia artificial como base. Durante la última presentación del Google I/O, la compañía nos mostró, además de todos sus nuevos modelos de Gemini, un pequeño ápice de su visión sobre el futuro de los asistentes con IA. Bajo estas líneas te contamos todo sobre Project Astra, el asistente más innovador de la compañía.

Project Astra es la visión que tiene Google sobre los asistentes con IA del futuro

Si has visto alguna vez la película de 'Her', te habrás dado cuenta que el protagonista (interpretado por Joaquin Phoenix) interactúa de forma muy humana y natural con una inteligencia artificial general y multipropósito que se encuentra muy integrada en la vida de este protagonista.

Si bien el trascurso de la película y su final nos dan a entender una perspectiva preocupante sobre el uso de esta tecnología, lo cierto es que esta es un poco la meta que tienen las grandes compañías en torno al uso de la IA, es decir, una inteligencia artificial general (AGI) con la que podamos interactuar sobre cualquier dispositivo y que nos pueda facilitar y ayudar en innumerables tareas de nuestro día a día.

Para Google, su visión sobre el futuro de la IA pasa por Project Astra, un asistente impulsado por inteligencia artificial que puede responder e interactuar con todo nuestro entorno mediante la ayuda de una cámara y un dispositivo que logre procesar esa interacción en base al modelo de lenguaje interno.

Este dispositivo puede ser tanto un teléfono móvil, como unas gafas inteligentes (¿recuerdas Google Glasses?), tablet, Smart TV, ordenador, o cualquier otro dispositivo. Esta inteligencia artificial estaría al tanto del contexto de la conversación y nuestro alrededor en todo momento, haciendo uso de las capacidades del dispositivo y ofreciendo sus respuestas en base al LLM (Large Language Model) que utilice para su funcionamiento.

Tal y como podemos ver en el vídeo mostrado durante la presentación, la usuaria interactúa con el asistente a través de la cámara de su móvil, dándole contexto en todo momento a la IA para que pueda interactuar además con el entorno y ofrecer respuestas ágiles y coherentes.

En la segunda mitad del vídeo, vemos que suelta el móvil y utiliza unas gafas inteligentes con cámara incorporada, continuando la conversación a través de este nuevo dispositivo. Google Glasses tenía un problema: su software y el hecho de que salieran al mercado en un momento en el que no estábamos preparados para ello. Sin embargo, con la ayuda de la IA, el panorama ha cambiado por completo, por lo que es muy posible que este tipo de dispositivos comiencen a frecuentar las calles en un futuro no muy lejano.

Algunas de las capacidades que se muestran aparecerán próximamente en los servicios de Google, así como en la app de Gemini para dispositivos móviles que llegaría más adelante durante este año. Con Project Astra, Google quiere que esa interacción que vemos en la película de 'Her' esté más cerca de lo que creemos. De momento conocemos poco sobre ello, por lo que esperemos que durante los próximos meses sepamos más novedades en torno a esa visión que Google nos tiene preparada.

Imagen de portada | Google

Más información | Google

En Genbeta | Google tiene 11 cursos gratis para aprender machine learning desde cero y en castellano

-

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

La Starliner y su cohete de vuelta al «taller» – NASA Commercial Crew

Sí, es el cuento de nunca acabar: Boeing acaba de anunciar que el primer lanzamiento tripulado de su cápsula espacial Starliner se retrasa de nuevo. En esta ocasión al menos hasta las 22:43, hora peninsular española (UTC +2) del martes 21 de mayo.

No es, ni con mucho el primer aplazamiento de esta misión: ya fue aplazada en el verano de 2021 y de nuevo en el de 2023. Y eso después de que su primer lanzamiento no tripulado en 2019 terminara en un sonado fracaso que obligó a repetir la misión en mayo de 2022.

Así que es un lanzamiento en el que Boeing y la NASA se juegan mucho.

La Calypso, que así se llama la Starliner que llevará a cabo esta misión, estuvo a punto de despegar el pasado día 7. Pero con Butch Wilmore y Sunita Williams ya a bordo el comportamiento errático de una válvula de purga de oxígeno de la etapa superior Centaur del cohete Atlas V que iba a lanzarla obligó a posponer el lanzamiento.

De hecho el cohete y la cápsula fueron devueltos al edificio de integración vertical en el que se hacen los últimos preparativos para el lanzamiento para cambiar la válvula en cuestión. Mientras hacían el cambio el lanzamiento estaba programado para el sábado 18 de mayo a las 00:16.

Pero una vez cambiada la válvula y mientras se hacían unas pruebas del sistema de combustible del módulo de servicio de la Starliner apareció una pequeña fuga de helio. Es un gas inerte que se utiliza para presurizar el sistema y asegurarse de que los propelentes se mueven de la forma adecuada y a la presión adecuada. Así que es necesario tiempo extra para localizar la fuga, sellarla, y volver a probar todo a presión de vuelo.

El objetivo de la misión, conocida como Boeing Crew Flight Test (Vuelo tripulado de prueba de Boeing, Boe CFT, o CFT a secas) es hacer pasar una Starliner por todas las fases de una misión tripulada a la Estación Espacial Internacional (EEI) con la idea de certificarla para entrar en servicio. Aunque en lugar de una misión de seis meses será una misión de algo más de una semana.

Para quienes estamos a este lado del charco el horario es sin duda mejor, ya que el lanzamiento se producirá por la noche y no de madrugada. Podrá ser visto a través de Internet vía NASA TV.

# Enlace Permanente

Publicado el 14/05/2024 por Diario Tecnología

Artículo original

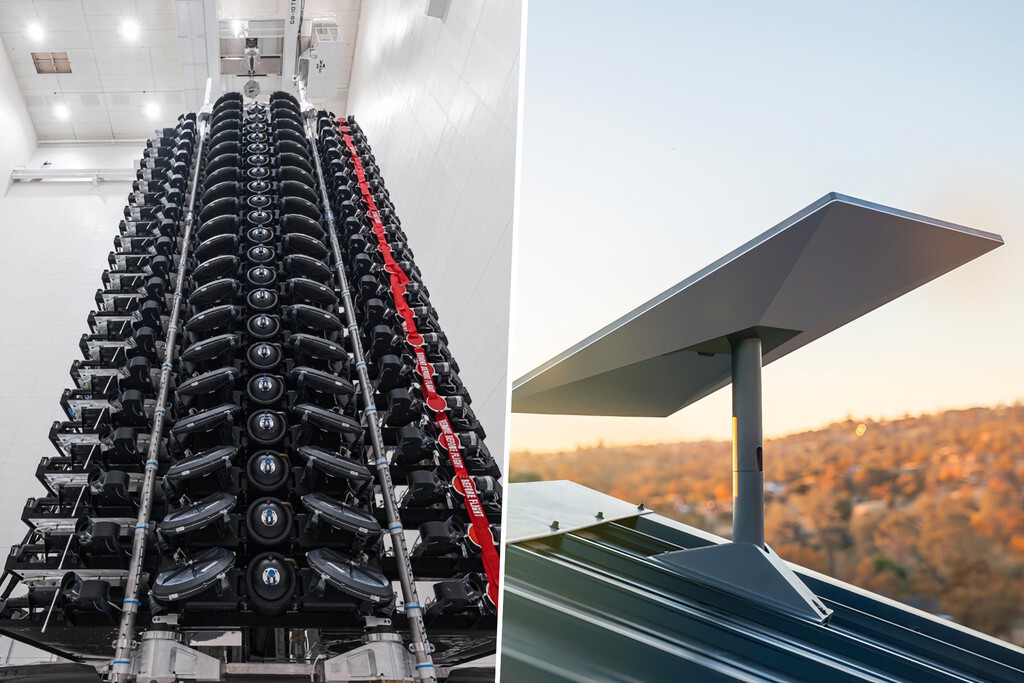

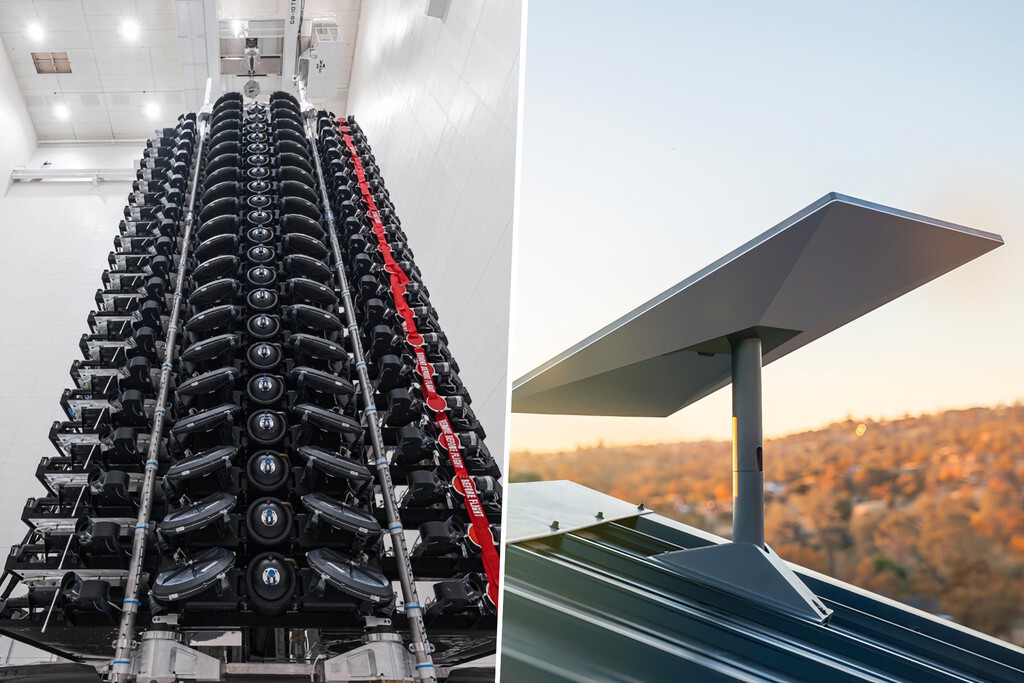

SpaceX ha encontrado en Starlink su gallina de los huevos de oro. La propia empresa fabrica, lanza y comercializa sus satélites de Internet de banda ancha en todo el mundo. Pero el rápido crecimiento tiene un lado negativo para los usuarios, especialmente los que viven en zonas donde la demanda del servicio es alta.

6.600 millones de dólares en ingresos. Es lo que los analistas de Quilty Space esperan que Starlink facture en 2024:

Tampoco salen mal paradas las cuentas para Starlink en la casilla de EBITDA (ganancias antes de intereses, impuestos, depreciación y amortización). 3.800 millones de dólares en 2024, proyecta Quilty Space. Un salto de rentabilidad espectacular, teniendo en cuenta que el EBITDA del servicio fue de -128 millones de dólares en 2022. Y faltan por llegar los ingresos del nuevo servicio celular.

Un crecimiento vertiginosa. La fórmula con la que Starlink ha salido de números rojos no es ningún secreto. SpaceX tiene previsto lanzar 144 cohetes en 2024, casi tres por semana; la mayoría, con satélites Starlink.

Starlink opera más de 6.000 satélites en la órbita baja terrestre y cuenta ya con 2,7 millones de clientes en 75 países. Argentina y Uruguay han sido lo últimos en incorporarse a la creciente lista. Nada mal para una constelación que se ha construido fundamentalmente en los últimos tres años.

La mala noticia: subidas de precio. A pesar de la cantidad de satélites en órbita, y aunque estos sean capaces de comunicarse entre ellos mediante enlaces láser, SpaceX ha anunciado subidas de precio en zonas donde la demanda es tan alta que supera la capacidad de la red.

Empezando por Estados Unidos, donde los clientes de áreas con "capacidad de Starlink limitada" pasarán de pagar 90 dólares al mes a pagar 120; una subida de 30 dólares mensuales que se hará efectiva el 10 de junio. En contraste, los clientes de áreas con "exceso de capacidad" pagarán 90 dólares por el servicio.

La ventaja de reutilizar los cohetes. El problema de la demanda tiene fácil solución: seguir lanzando satélites hasta completar la constelación previsto de 12.000. Y por suerte para Starlink, el Falcon 9 de SpaceX es el único cohete de carga media con un propulsor capaz de aterrizar para volver a usarse.

En un principio, SpaceX lanzaba más de 60 satélites Starlink por vuelo, pero cuando los satélites se volvieron más grandes, pesados y potentes (especialmente con la generación V2 mini), los lanzamientos se redujeron a lotes de 23.

Los futuros Starlink V3 serán aún más grandes, pesados y potentes. Sin embargo, SpaceX espera seguir sacándoles rentabilidad gracias a la nave Starship, capaz no solo de lanzar más de 100 toneladas, sino de hacerlo cada pocas horas.

Imagen | SpaceX

En Xataka | Starlink tiene miles de cámaras instaladas en el espacio. La gente lo ha descubierto porque han grabado el eclipse

-

Página Siguiente